Prologo: La Computación Cuántica (CC) se ha establecido como una de las revoluciones tecnológicas más trascendentales del siglo XXI, con el potencial de abordar problemas de optimización y simulación que son inabordables para los ordenadores clásicos. El paradigma cuántico utiliza el cúbit, una unidad que aprovecha la superposición y el entrelazamiento para ofrecer una capacidad de procesamiento masivo en paralelo. Sin embargo, el campo se encuentra actualmente en la era NISQ (Dispositivos Cuánticos de Escala Intermedia Ruidosa), caracterizada por la alta tasa de error y la decoherencia, lo que exige la implementación de la Corrección de Errores Cuánticos (QECC) para alcanzar la Computación Tolerante a Fallos (FTQC). El impacto más crítico de la CC reside en la criptografía, pues el Algoritmo de Shor amenaza la seguridad de los esquemas RSA y ECC, lo que impulsa la migración inmediata a la Criptografía Post-Cuántica (PQC). De forma constructiva, la CC es la herramienta idónea para la simulación molecular y el estudio detallado de interacciones químicas, prometiendo una ventaja fundamental en el descubrimiento de nuevos materiales y fármacos. Respecto a la Inteligencia Artificial, la estrategia más pragmática para la utilidad actual es el modelo híbrido (Quantum Boosting), que delega tareas específicas de optimización al hardware cuántico para mitigar desafíos como el problema de la Meseta Estéril (Barren Plateau).

Indice-Contenido:

- Introducción Estratégica: (La CC)

- Fundamentos Físicos y Computacionales: (Bits Clásicos vs. Qubits)

- El Estado de la Cuestión: (De la Era NISQ a la Tolerancia a Fallos)

- Impacto Futuro Potencial a Largo Plazo: (Tres Ejes Críticos)

- Desafíos Estratégicos y Panorama Geopolítico:

- Conclusiones y Resumen Estratégico:

Resumen de Audio:

Computación Cuántica: (Impacto Futuro Profundo)

-. El texto proporciona un análisis estratégico profundo sobre la Computación Cuántica (CC), comparando su potencial transformador con el de la inteligencia artificial. Explico que la CC se basa en principios como la superposición y el entrelazamiento para superar las limitaciones de la computación clásica, aunque actualmente opera en la era NISQ (Dispositivos Cuánticos de Escala Intermedia Ruidosa) debido a problemas de decoherencia. Estratégicamente, se identifican tres áreas de impacto clave: la criptografía, donde el algoritmo de Shor representa una amenaza existencial mitigada por la Criptografía Post-Cuántica (PQC); la Inteligencia Artificial Cuántica (QML), que se enfoca en modelos híbridos debido a desafíos como el Barren Plateau; y la simulación de materiales, considerada el eje con mayor potencial industrial en el corto plazo. Finalmente, subrayo la carrera geopolítica por la supremacía cuántica y la crítica necesidad de invertir en talento especializado para la corrección de errores cuánticos.

1. Introducción Estratégica: (CC)

1.1. Propósito del Informe y Relevancia Global de la CC

-. La Computación Cuántica (CC) ha emergido como una de las revoluciones tecnológicas más trascendentales del siglo XXI, siendo comparable en impacto potencial al advenimiento de la inteligencia artificial (IA). Esta disciplina promete la capacidad de resolver problemas de optimización y simulación que son inabordables para los ordenadores clásicos más avanzados. El objetivo fundamental de este post es proporcionar un análisis exhaustivo y estratégico, delineando los fundamentos, el estado actual de la ingeniería y el impacto potencial a largo plazo de la CC en tres sectores críticos: la criptografía, la inteligencia artificial y el desarrollo de nuevos materiales.

-. El campo de la computación cuántica está impulsado por la promesa de abordar algunos de los desafíos más complejos a nivel global, incluyendo el desarrollo de nuevos tratamientos médicos, la mitigación de los efectos del cambio climático y la aceleración de la investigación en machine learning.

1.2 La CC como Catalizador de la Próxima Revolución Tecnológica

-. La CC se distingue por su naturaleza profundamente interdisciplinaria, uniendo física, ingeniería y ciencias de la computación. La ambición global se centra en la aceleración de este campo desde la investigación fundamental hasta la aplicación comercial, con un claro objetivo estratégico de convertir el conocimiento científico en innovación que defina la competitividad económica del siglo XXI.

-. Desde una perspectiva estratégica, la computación cuántica y la inteligencia artificial no son esferas separadas, sino fuerzas convergentes. El futuro de la innovación tecnológica será fundamentalmente híbrido. La CC se posiciona como un motor de la IA, especialmente al resolver cuellos de botella algorítmicos que involucran la optimización de complejidad exponencial. Por ejemplo, si los algoritmos cuánticos pueden reducir significativamente el tiempo de entrenamiento y la optimización de hiperparámetros para modelos de IA complejos , la CC se convierte en un multiplicador de fuerza para el desarrollo de la próxima generación de sistemas de inteligencia artificial.

2. Fundamentos Físicos y Computacionales: (Bits Clásicos vs. Qubits)

2.1. El Paradigma Cuántico: (Bits Clásicos vs. Qubits)

-. La computación cuántica se basa enteramente en los principios de la mecánica cuántica, un marco físico que opera con una lógica que contrasta fuertemente con la intuición derivada de la física tradicional.

-. La unidad fundamental de información en la computación clásica es el bit, que existe en un estado binario discreto (0 o 1). En contraste, el cúbit es la unidad de procesamiento cuántica. El cúbit aprovecha el principio de superposición, lo que le permite existir simultáneamente como una combinación lineal de los estados |0⟩ o |1⟩ Esta capacidad dual de estado es el origen del potencial de procesamiento masivo en paralelo inherente a los sistemas cuánticos. Los cúbits no se limitan a un sustrato físico; pueden construirse a partir de iones atrapados, fotones, átomos artificiales o reales, o circuitos electrónicos superconductores, y algunas implementaciones requieren que se mantengan a temperaturas cercanas al cero absoluto.

2.2. Principios Clave: (Superposición, Entrelazamiento e Interferencia Cuántica)

Nota: La ventaja computacional cuántica se deriva de la explotación coordinada de tres principios:

-. La superposición permite que, con N cúbits, el sistema explore 2N estados de manera simultánea. El entrelazamiento (entanglement) es, sin embargo, el recurso cuántico más potente. Consiste en un vínculo no separable entre dos o más cúbits. Un sistema de cúbits entrelazados experimenta un aumento exponencial en su capacidad de cálculo a medida que el número de unidades entrelazadas crece. La manipulación de estos estados se realiza mediante la interferencia cuántica, donde las compuertas cuánticas dirigen el cálculo para amplificar la probabilidad de encontrar la respuesta correcta y suprimir las incorrectas.

2.3. Arquitecturas de Hardware Cuántico: (Avances y Desafíos Arquitectónicos)

Nota: La ingeniería cuántica se encuentra en una etapa de proliferación arquitectónica, con una fuerte competencia entre diferentes enfoques para la implementación del cúbit:

- Superconductores: Circuitos electrónicos superconductores que actúan como «átomos artificiales» constituyen la base de muchas de las computadoras cuánticas más desarrolladas actualmente. Su principal limitación operativa es su extrema fragilidad ante la perturbación y el requerimiento de entornos criogénicos ultrabajos.

- Iones Atrapados y Átomos de Rydberg: Estas plataformas ofrecen una alta fidelidad en las compuertas y tiempos de coherencia comparativamente más largos. Los procesadores basados en átomos neutros de Rydberg han demostrado la capacidad de construir sistemas escalables con grandes recuentos de cúbits (ejemplos reportados superan los 1,200 cúbits).

- Fotónica: Aunque prometedora para la distribución de información, la implementación de compuertas lógicas de dos cúbits en arquitecturas fotónicas presenta desafíos debido a la baja interacción natural entre fotones.

-. La existencia de esta diversidad de arquitecturas (superconductores, iones, fotones ) sugiere que la industria se encuentra en una etapa pre-estándar. Esta fragmentación arquitectónica conlleva importantes implicaciones en la ingeniería de software. Los algoritmos cuánticos deben adaptarse a la topología específica del hardware (por ejemplo, adaptando circuitos a la topología de un chip IBM Falcon ), lo que limita la portabilidad y eleva la curva de aprendizaje para el desarrollo de aplicaciones.

3. El Estado de la Cuestión: (De la Era NISQ a la Tolerancia a Fallos)

-. El texto ofrece un análisis del estado actual y los desafíos de la computación cuántica, centrándose en la Era NISQ (Dispositivos Cuánticos de Escala Intermedia Ruidosa).

-. El estado actual de la computación cuántica se caracteriza por la Era NISQ (Noisy Intermediate-Scale Quantum devices), marcada por un número intermedio de cúbits físicos (ejemplos comunes son procesadores con 53 a 65 cúbits ) que adolecen de alta tasa de error (ruido) y tiempos de coherencia cortos. Estas limitaciones impiden la ejecución a escala de algoritmos complejos como el de Shor o el de Grover. El desafío central es la decoherencia, considerada «el mayor problema de los ordenadores cuánticos» , ya que la interacción no deseada con el entorno anula los efectos cuánticos.

-. La superación de la fragilidad del hardware exige la Corrección de Errores Cuánticos (QECC) para alcanzar la Computación Cuántica Tolerante a Fallos (FTQC). Un sistema FTQC requiere una redundancia inmensa, donde cúbits–lógicos robustos se construyen a partir de un gran número de cúbits–físicos ruidosos, y se estima que existe un «abismo» de 10,000X entre la capacidad actual de los dispositivos NISQ y las especificaciones necesarias para las aplicaciones transformadoras. Este requisito eleva la importancia de la Gestión de Recursos Cuánticos (QRE) en la ingeniería de software. Las hojas de ruta estratégicas apuntan a la Ventaja Cuántica Industrial para problemas específicos de optimización hacia el horizonte 2030, mientras que el despliegue a escala de la FTQC se proyecta más allá, probablemente en la década de 2030 o 2040.

4. Impacto Futuro Potencial a Largo Plazo: (Tres Ejes Críticos)

-. La Computación Cuántica (CC) tiene un impacto potencial a largo plazo que se materializa a través de tres ejes críticos: la ciberseguridad, la inteligencia artificial y el desarrollo de nuevos materiales. La amenaza estratégica más tangible es el Algoritmo de Shor, capaz de factorizar números grandes y romper la seguridad de los esquemas criptográficos de clave pública, requiriendo urgentemente el despliegue de la Criptografía Post-Cuántica (PQC), liderada por la estandarización del NIST. En el campo de la Inteligencia Artificial, el Aprendizaje Automático Cuántico (QML) busca acelerar la optimización combinatoria y el análisis de grandes datos, a pesar de enfrentarse a desafíos como la Meseta Estéril, lo que impulsa enfoques híbridos pragmáticos. Asimismo, la simulación cuántica ofrece una Ventaja Cuántica fundamental para el modelado de sistemas complejos de muchos cuerpos y las interacciones moleculares, acelerando el descubrimiento de fármacos y materiales superconductores, lo que a su vez simplificará el hardware cuántico futuro.

4.1. Criptografía y Ciberseguridad:

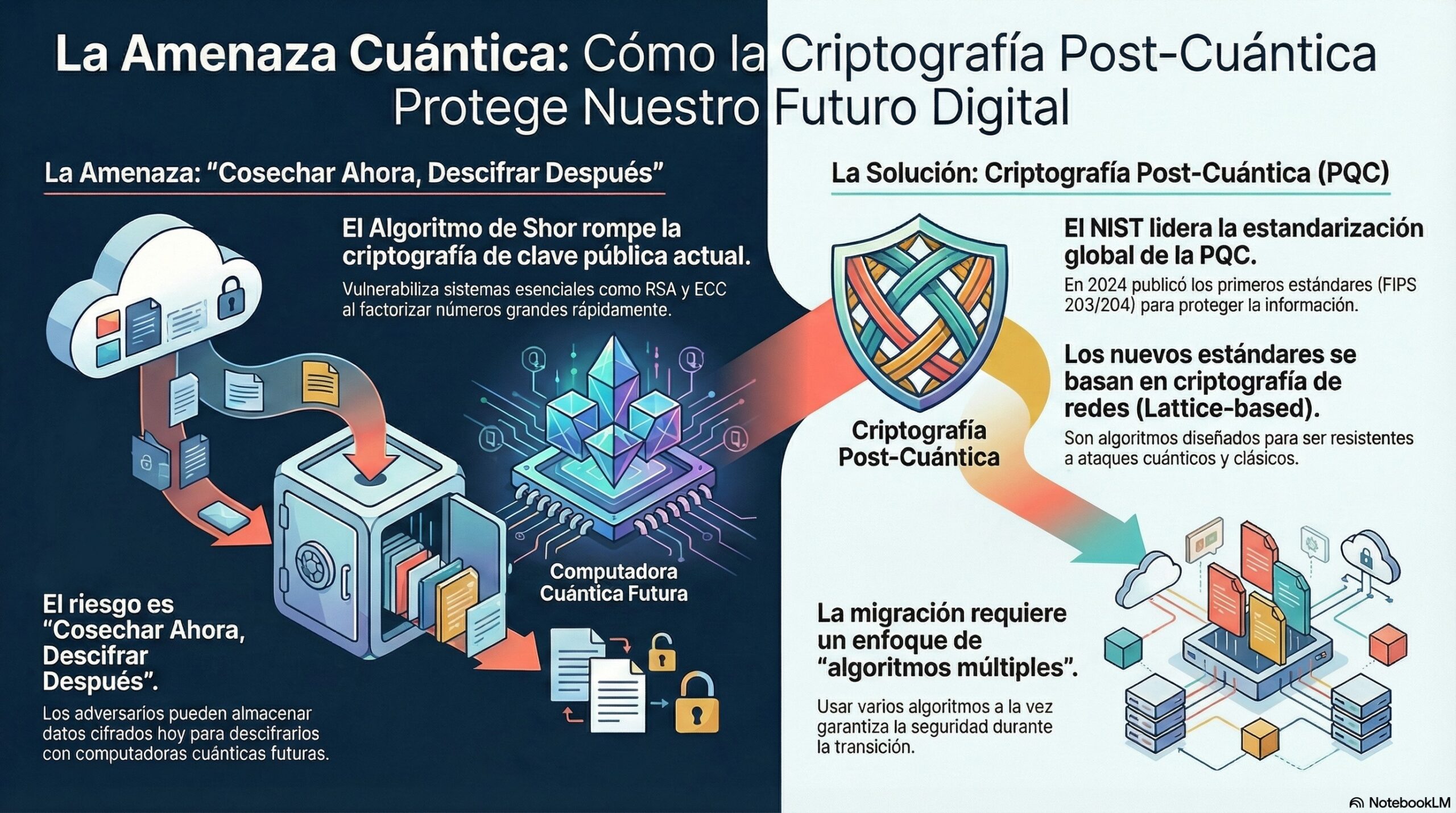

-. La principal amenaza estratégica de la CC se materializa a través del Algoritmo de Shor, que tiene la capacidad de factorizar números grandes en tiempo polinómico, rompiendo la seguridad de los esquemas criptográficos de clave pública más utilizados, como RSA y ECC. Esto crea un riesgo de seguridad a largo plazo conocido como Harvest Now, Decrypt Later, donde los datos cifrados hoy pueden ser almacenados y descifrados una vez que se alcance la Computación Cuántica Tolerante a Fallos (FTQC). La estrategia de mitigación es el despliegue de la Criptografía Post-Cuántica (PQC), con el NIST liderando la estandarización global de algoritmos resistentes a ataques cuánticos. En 2024, el NIST publicó sus primeros estándares PQC (FIPS 203/ML-KEM y FIPS 204/ML-DSA), basados principalmente en criptografía de redes (Lattice-based). La migración exige la adopción de un enfoque de «algoritmos múltiples» para garantizar la seguridad durante la compleja transición.

4.1.Una representación visual de información: (Infografía)

4.2 : Inteligencia Artificial y Aprendizaje Automático Cuántico (QML)

-. El Aprendizaje Automático Cuántico (QML) tiene como objetivo principal acelerar la optimización combinatoria, el entrenamiento de modelos de IA y el análisis eficiente de grandes volúmenes de datos (ej. logística y finanzas). Los investigadores exploran algoritmos cuánticos como las Quantum Support Vector Machines (QSVM) y las Redes Neuronales Cuánticas (QNN). Sin embargo, el QML se enfrenta a la barrera fundamental de la Meseta Estéril (Barren Plateau), un fenómeno que ocurre en circuitos variacionales profundos donde los gradientes de optimización se anulan, impidiendo que el algoritmo aprenda. Debido a las limitaciones del hardware NISQ, la estrategia más pragmática es el enfoque híbrido (Quantum Boosting), que utiliza el procesador cuántico para tareas específicas de aceleración mientras mantiene la robustez del aprendizaje automático clásico.

4.2. Una representación visual de información: (Infografía)

4.3. Desarrollo de Nuevos Materiales y Simulación Molecular

-. La simulación cuántica ofrece una Ventaja Cuántica fundamental en el modelado de sistemas de muchos cuerpos y las interacciones moleculares, cuya complejidad exponencial los hace intratables para la computación clásica. Esto acelera el descubrimiento de fármacos (como lo demuestra la exploración de Biogen ) y catalizadores, además de ser crucial para el desarrollo de materiales con propiedades específicas, como los superconductores de alta temperatura. Los algoritmos híbridos de la era NISQ, como el Variational Quantum Eigensolver (VQE) y QAOA , se están utilizando para determinar la energía de estado fundamental de moléculas (H2), a menudo empleando técnicas como la extrapolación de ruido cero para mitigar los fallos del hardware. Este eje es de importancia estratégica por el ciclo de retroalimentación: el éxito en la simulación cuántica podría conducir al diseño de materiales superconductores que, a su vez, simplificarían y abaratarían el hardware cuántico futuro.

5. Desafíos Estratégicos y Panorama Geopolítico

5.1. La Carrera por la Supremacía Cuántica: (Análisis de la Competencia Global)

-. La computación cuántica es un foco de intensa rivalidad geopolítica, comparable en importancia a la IA. La carrera por el liderazgo cuántico está en curso, impulsada principalmente por Estados Unidos, China y la Unión Europea.

-. Esta competencia se manifiesta en la inversión estratégica en investigación y desarrollo, el análisis de liderazgo en patentes , y la movilización de recursos públicos y privados para definir la supremacía tecnológica en el siglo XXI. La capacidad para controlar esta tecnología tiene implicaciones directas en la seguridad nacional y el poder económico.

5.2. Implicaciones Económicas y de Talento Especializado

Nota: La transición hacia una «economía cuántica» exige una inversión equilibrada en capital, infraestructura y, fundamentalmente, talento especializado.

-. Existe una escasez global de expertos capaces de manejar la complejidad de los sistemas cuánticos. La necesidad de diseñar algoritmos variacionales en la era NISQ y de implementar protocolos robustos de QRE requiere una experiencia profunda que actualmente es limitada. La inversión en la formación de este capital humano se considera una prioridad estratégica, ya que la disponibilidad de talento será el cuello de botella que determine la velocidad y la dirección de la «carrera cuántica» para los próximos años.

Una representación visual de información: (Infografía)

6. Conclusiones y Resumen Estratégico:

6.1. Síntesis del Estado Actual

-. La Computación Cuántica se encuentra en una etapa NISQ, limitada por la decoherencia y el ruido, que impiden la ejecución del FTQC a escala. Sin embargo, ya se han logrado avances fundamentales en la simulación molecular y en la optimización híbrida. La ingeniería se concentra en la Corrección de Errores Cuánticos (QECC) para cerrar la brecha de 10,000X que separa el hardware actual de las aplicaciones transformadoras.

6.2. Proyecciones Estratégicas y Recomendaciones

Nota: El análisis exhaustivo de los tres ejes críticos conduce a las siguientes conclusiones estratégicas:

- Criptografía (Riesgo Iminente): El riesgo del Algoritmo de Shor es existencial para la infraestructura de seguridad actual. La mitigación (PQC) es un imperativo que no puede posponerse, ya que la ventana de tiempo para la migración a los nuevos estándares NIST (ML-KEM, ML-DSA) es más corta que el horizonte de llegada del FTQC.

- Materiales y Química Cuántica (Ventaja Robusta): Este campo ofrece la ventaja cuántica más fundamental y potencialmente la más cercana a la realización industrial. Los algoritmos VQE ya están probando la superación de las capacidades clásicas en la simulación de sistemas de muchos cuerpos. Se recomienda invertir en ecosistemas que permitan el ciclo de retroalimentación, donde la CC simula materiales para mejorar el propio hardware cuántico.

- Inteligencia Artificial (Modelo Híbrido): El QML se enfrentará a barreras críticas de escalabilidad, notablemente el Barren Plateau. La estrategia más rentable y robusta se basa en el modelo híbrido (Quantum Boosting), utilizando la CC para acelerar tareas específicas de optimización combinatoria (logística, finanzas) en lugar de intentar construir Redes Neuronales Cuánticas puras que requieran FTQC.

- Recursos Estratégicos: La escasez de talento especializado en QECC y QRE es el principal factor limitante. La inversión en capital humano que entienda tanto la física como la ingeniería de software cuántico es esencial para mantener la competitividad en la carrera cuántica global.

Recopilando:

-. Veamos los puntos mas importantes de este post:

- La Computación Cuántica (CC) ha emergido como una de las revoluciones tecnológicas más trascendentales del siglo XXI, comparable en impacto potencial al advenimiento de la Inteligencia Artificial (IA).

- La CC tiene el potencial de resolver problemas complejos de optimización y simulación que son inabordables para los ordenadores clásicos más avanzados.

- La unidad fundamental de procesamiento cuántico es el cúbit, el cual aprovecha el principio de superposición para existir simultáneamente como una combinación de los estados ∣0⟩ o ∣1⟩.

- La superposición permite que un sistema de N cúbits explore 2N estados de manera simultánea, lo que origina la capacidad de procesamiento masivo en paralelo.

- El entrelazamiento es el recurso cuántico más potente, creando un vínculo no separable entre cúbits que aumenta exponencialmente la capacidad de cálculo.

- Actualmente, el campo se encuentra en la Era NISQ (Dispositivos Cuánticos de Escala Intermedia Ruidosa), caracterizada por un número intermedio de cúbits físicos y una alta tasa de error.

- El desafío central de la era NISQ es la decoherencia, considerada «el mayor problema de los ordenadores cuánticos» porque anula los efectos cuánticos deseados.

- Para superar la fragilidad del hardware, es necesaria la Corrección de Errores Cuánticos (QECC) para alcanzar la Computación Cuántica Tolerante a Fallos (FTQC).

- El impacto estratégico más tangible y crítico de la CC reside en la ciberseguridad, debido a la amenaza del Algoritmo de Shor.

- El Algoritmo de Shor tiene la capacidad de romper la seguridad de los esquemas criptográficos de clave pública actuales, como RSA y ECC, al factorizar números grandes rápidamente.

- La mitigación urgente a esta amenaza es la Criptografía Post-Cuántica (PQC), con el NIST liderando la estandarización global de algoritmos resistentes a ataques cuánticos, basados principalmente en criptografía de redes.

- En el ámbito de la Inteligencia Artificial (IA), la estrategia más pragmática es el modelo híbrido (Quantum Boosting), que delega tareas específicas de optimización al hardware cuántico.

- El Aprendizaje Automático Cuántico (QML) puro se enfrenta a la barrera fundamental de la Meseta Estéril (Barren Plateau), que impide el aprendizaje al anular los gradientes de optimización en circuitos profundos.

- La simulación cuántica ofrece una Ventaja Cuántica fundamental para el modelado de sistemas de muchos cuerpos e interacciones moleculares, acelerando el descubrimiento de fármacos y nuevos materiales.

- La escasez global de talento especializado en QECC y Gestión de Recursos Cuánticos (QRE) se considera el cuello de botella principal que determinará la velocidad de la «carrera cuántica».

- Referencias: moreluz.entorno

- Referencias: Cisco

- Referencias: NotebookLM