Prologo: La computación cuántica ha dejado de ser una disciplina teórica para consolidarse como un campo de ingeniería de vanguardia en el umbral de 2025. Actualmente, el interés industrial se ha desplazado del simple conteo de qubits físicos hacia la validación de la corrección de errores cuánticos (QEC) y la estabilidad operativa. Hitos como la supresión de errores de Google y la operación continua de QuEra confirman que el hardware ha alcanzado el umbral necesario para que la redundancia cuántica sea beneficiosa. El diseño de sistemas a gran escala ahora integra electrónica Cryo-CMOS y códigos LDPC para mitigar el ruido térmico y reducir drásticamente el exceso de qubits físicos requeridos. Sectores como la banca y la farmacéutica están liderando la adopción comercial, buscando superar los límites físicos de la computación clásica mediante algoritmos de optimización y simulación molecular. El éxito hacia 2030 dependerá tanto de la fidelidad de las puertas lógicas como del desarrollo de una fuerza laboral capacitada para gestionar la infraestructura de la era fault-tolerant.

Indice-Contenido:

- Fundamentos Físicos: (Ingeniería de la Información Cuántica)

- Taxonomía de Errores: (y el Desafío de la Decoherencia)

- Arquitecturas de Hardware: (Estado de la Cuestión en 2025)

- Corrección de Errores Cuánticos: (QEC), (El Puente hacia la Utilidad)

- Desafíos de Ingeniería: (en la Escalabilidad)

- El Camino a la Comercialización: (2025-2030)

- Implicaciones: (Geopolíticas y de Talento)

Resumen de Audio:

Ingeniería de Sistemas Cuánticos

-. La computación cuántica ha dejado de ser una disciplina puramente teórica para transformarse en un campo de ingeniería de vanguardia. En el umbral de 2025, la industria se encuentra en un punto de inflexión crítico, donde la atención ha pasado del recuento bruto de qubits-físicos a la demostración de la corrección de errores cuánticos (QEC) y la estabilidad operativa. El propósito de este informe es desglosar de manera exhaustiva los fundamentos, los obstáculos técnicos y las estrategias de escalabilidad que definirán la utilidad de estos sistemas en la próxima década.

1. Fundamentos Físicos: (Ingeniería de la Información Cuántica)

-. Para un ingeniero de sistemas, comprender la computación cuántica requiere una transición desde la lógica binaria clásica hacia la mecánica de ondas y la probabilidad compleja. La unidad fundamental, el qubit, no está limitada a valores discretos; su estado se define mediante una superposición de bases:

1.1. Superposición y Entrelazamiento: (como Recursos Computacionales)

-. La superposición permite que los qubits procesen una vasta gama de configuraciones simultáneamente. Sin embargo, la verdadera potencia de ingeniería surge del entrelazamiento-cuántico. Este fenómeno crea correlaciones no locales entre qubits, de modo que el estado de uno no puede describirse de forma independiente de los demás, incluso si están separados por distancias macroscópicas. En términos de diseño de algoritmos, esto permite una expansión exponencial del espacio computacional: mientras que n bits-clásicos representan un solo estado de n dígitos, n qubits entrelazados pueden representar 2n estados concurrentes.

-. La interferencia cuántica actúa como el mecanismo de control para navegar este espacio. Al manipular las fases de las funciones de onda, los ingenieros diseñan circuitos que utilizan la interferencia constructiva para amplificar la probabilidad de medir la respuesta correcta, mientras emplean la interferencia destructiva para cancelar las trayectorias de cálculo erróneas.

1.2. El Problema de la Coherencia: (el Teorema de No-Clonación)

-. La estabilidad de estos estados, denominada coherencia, es extremadamente efímera. La interacción con el entorno provoca la decoherencia, un proceso donde la información cuántica se degrada y el sistema colapsa hacia un estado clásico debido al ruido térmico, electromagnético o vibratorio. A diferencia de los sistemas clásicos, la información cuántica no se puede copiar fielmente para crear copias de seguridad debido al teorema de no-clonación, lo que impone una restricción de ingeniería única: la redundancia debe lograrse a través del entrelazamiento en códigos de corrección de errores, no mediante la duplicación simple.

2. Taxonomía de Errores: (y el Desafío de la Decoherencia)

-.El principal obstáculo para la escalabilidad de los sistemas-cuánticos es el ruido ambiental. La decoherencia limita el tiempo de vida útil de un qubit, restringiendo la profundidad de los circuitos (el número de puertas lógicas que pueden ejecutarse antes de que los resultados sean indistinguibles del ruido aleatorio).

2.1. Fuentes de Inestabilidad en el Hardware

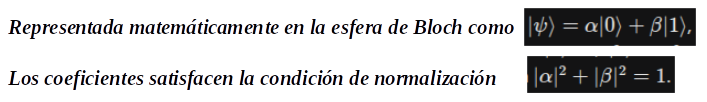

Nota: En la ingeniería cuántica de 2025, se han identificado tres categorías principales de errores que degradan la fidelidad de las operaciones:

- Errores de Bit-Flip y Phase-Flip: Alteraciones en el estado de la base o en la relación de fase de la superposición.

- Inexactitud de Puertas Cuánticas: Imperfecciones en los pulsos de control (láseres o microondas) que conducen a rotaciones incompletas del estado del qubit en la esfera de Bloch.

- Errores de Medición: Incapacidad del sistema de lectura para distinguir con precisión entre el estado |0⟩ y el estado |1⟩ al final de un ciclo de cálculo.

-. Las tasas de error en el hardware actual oscilan entre el 0,1% y el 1%, una cifra astronómicamente alta si se compara con la fiabilidad de los transistores de silicio modernos. Para alcanzar la «ventaja cuántica«, estos sistemas deben implementar estrategias de supresión y mitigación de errores antes de poder ejecutar algoritmos de escala industrial.

Una representación visual de información: (Infografía)

Nota: Esta Infografía analiza los desafíos técnicos que enfrenta el hardware cuántico actual debido a sus elevadas tasas de fallo en comparación con la tecnología tradicional. El texto destaca que, para lograr una verdadera ventaja cuántica, es imprescindible aplicar métodos que logren mitigar y corregir errores operativos. Se detallan problemas específicos como la relajación por pérdida de energía, el desfasamiento en la superposición y las interferencias entre qubits adyacentes. Estas fallas surgen principalmente por la interacción del sistema con su entorno o por acoplamientos no deseados entre componentes. En última instancia, la fuente subraya que la estabilidad del sistema es el requisito fundamental para ejecutar algoritmos complejos a escala industrial. De este modo, se presenta un panorama crítico sobre la brecha existente entre los prototipos actuales y la computación funcional.

3. Arquitecturas de Hardware: (Estado de la Cuestión en 2025)

-. La carrera por la hegemonía cuántica se está librando en múltiples frentes tecnológicos. Cada arquitectura presenta un perfil de ingeniería distinto, con compromisos específicos entre velocidad, fidelidad y escalabilidad.

3.1. Circuitos Superconductores: (La Vía de la Fabricación en Estado Sólido)

. Los qubits superconductores, utilizados por IBM, Google y Rigetti, operan mediante circuitos macroscópicos que emplean uniones Josephson. Estos sistemas son valorados por su velocidad de operación (nanosegundos) y su compatibilidad con las técnicas de litografía de semiconductores existentes.

-. En 2024 y 2025, IBM ha desplegado procesadores como Condor (1.121 qubits) y la serie Heron, enfocándose en la modularidad y el empaquetado de alta fidelidad para reducir el ruido. Sin embargo, estos qubits requieren temperaturas criogénicas extremas (cerca de 10 mK), lo que genera un «cuello de botella de cableado» masivo a medida que se escala el número de unidades de control.

3.2. Iones Atrapados: (Precisión Atómica y Conectividad)

-. Empresas como IonQ y Quantinuum utilizan iones (átomos cargados) suspendidos en el vacío mediante campos electromagnéticos. La ventaja de ingeniería aquí es la identidad intrínseca de los qubits: cada ion de un isótopo específico es idéntico a cualquier otro, eliminando los defectos de fabricación presentes en los superconductores.

-. Los sistemas de iones-atrapados ofrecen tiempos de coherencia excepcionales (segundos o incluso minutos) y una fidelidad de puerta de dos qubits superior al 99,9%. No obstante, el escalamiento físico es un reto debido a la necesidad de mover físicamente los iones a través de una arquitectura QCCD (Quantum Charge-Coupled Device) para facilitar las interacciones, lo que introduce latencia operativa.

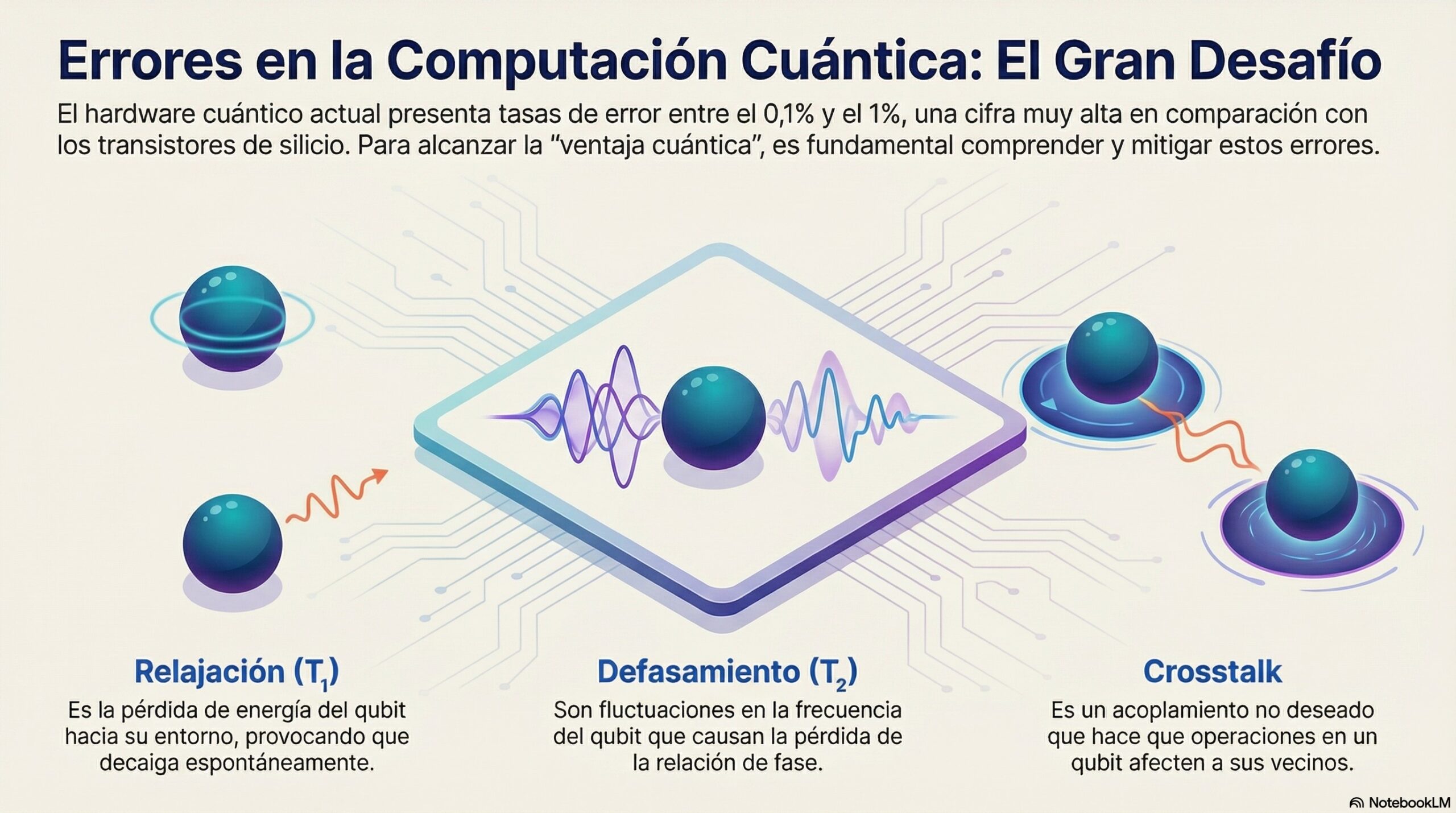

3.3. Átomos Neutros: (Escalado mediante Pinzas Ópticas)

-. La arquitectura de átomos neutros ha emergido en 2025 como una de las más prometedoras para el escalado masivo. Utilizando arreglos de láseres (pinzas ópticas), empresas como QuEra y Pasqal han demostrado la capacidad de controlar miles de átomos individuales sin necesidad de cableado físico por qubit.

Una representación visual de información: (Infografía)

Nota: Esta Infografía describe los avances de 2025 en la computación cuántica de átomos neutros, destacando su potencial para el escalado masivo de procesadores. Mediante el uso de pinzas ópticas impulsadas por láseres, empresas como QuEra han logrado gestionar hasta 3.000 cúbits físicos sin depender de conexiones eléctricas individuales. Este sistema innovador permite un control inalámbrico de las partículas dentro de una infraestructura de vacío que opera a temperatura ambiente. La tecnología garantiza una operación continua de más de dos horas gracias a la capacidad de reponer átomos de forma dinámica. En conjunto, el documento presenta esta arquitectura como una solución eficiente y altamente escalable frente a los métodos de computación tradicionales.

-. Un hito clave de 2025 fue la demostración de la reposición de qubits a mitad del cálculo, resolviendo el problema de la pérdida de átomos por colisiones con gases residuales.

4. Corrección de Errores Cuánticos: (QEC), (El Puente hacia la Utilidad)

-. La QEC es el proceso de codificar un qubit-lógico utilizando un grupo de qubits-físicos entrelazados. El objetivo es que la tasa de error del qubit-lógico sea órdenes de magnitud menor que la de sus componentes físicos, permitiendo cálculos indefinidamente largos.

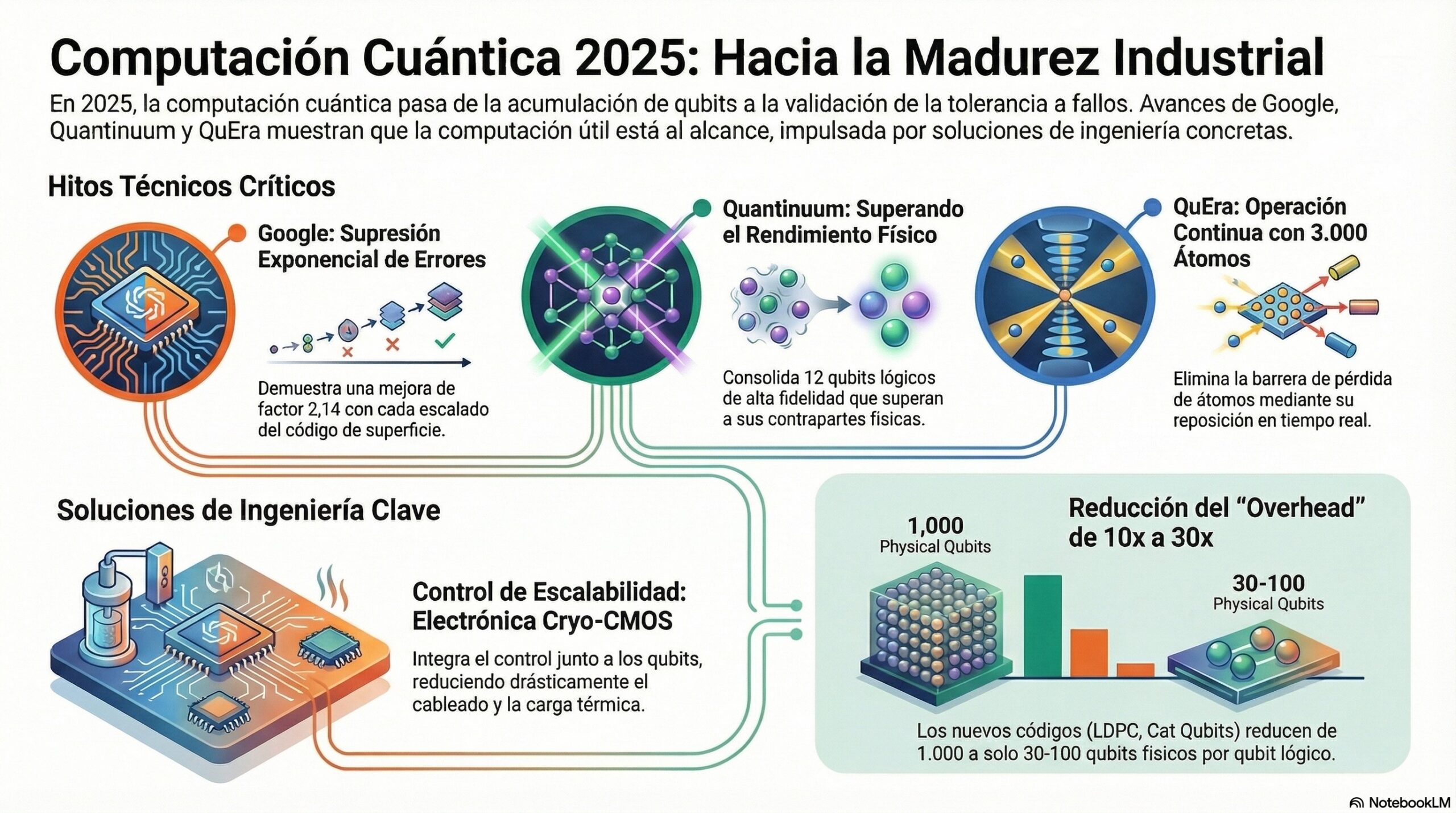

4.1. El Hito: (de Google con el Procesador Willow)

-. En diciembre de 2024, el equipo de Google-Quantum-AI publicó resultados que marcan un cambio cualitativo en el campo. Utilizando el procesador Willow, demostraron por primera vez una supresión de errores exponencial al aumentar el tamaño del código de superficie. Al escalar una red de qubits-físicos de 3×3 a 5×5 y finalmente a 7×7, la probabilidad de error lógico se redujo en un factor de 2,14 en cada etapa. Este experimento confirmó que el hardware ha alcanzado el «umbral de error» necesario para que la redundancia sea beneficiosa.

4.2. Innovaciones en Códigos: (LDPC y Cat Qubits)

-. La ingeniería de QEC tradicional impone un sobrecosto (overhead) masivo: a menudo se requieren 1.000 qubits-físicos para producir un solo qubit-lógico de alta fidelidad. Para reducir esta carga, han surgido dos vías tecnológicas disruptivas:

- Códigos LDPC (Low-Density Parity-Check): A diferencia de los códigos de superficie 2D, los códigos LDPC cuánticos permiten codificar múltiples qubits–lógicos en un bloque compacto de qubits-físicos con una conectividad más densa, reduciendo el overhead en un factor de 10 a 100.

- Cat Qubits: Desarrollados por Alice & Bob y AWS, estos qubits utilizan estados de oscilación en resonadores para protegerse intrínsecamente contra los errores de bit-flip. Esto simplifica la corrección de errores a una sola dimensión (phase-flip), permitiendo que un solo qubit-lógico se construya con apenas 30 cat qubits en lugar de los 1.000 habituales.

5. Desafíos de Ingeniería: (en la Escalabilidad)

-. A medida que los sistemas pasan de cientos a miles de qubits, surgen barreras infraestructurales que no existían en las demostraciones de pequeña escala.

5.1. El Problema de la Interconexión Criogénica:

-. En los sistemas superconductores, el calor generado por los miles de cables coaxiales necesarios para controlar los qubits supera la capacidad de enfriamiento de los refrigeradores de dilución estándar. La solución de vanguardia es la electrónica Cryo-CMOS.

-. Investigadores de la Universidad de Delft y Bluefors han desarrollado circuitos integrados en procesos de 22 nm que operan por debajo de los 70 mK (milikelvin). Estos chips realizan la generación de voltajes y el demultiplexado directamente en la etapa criogénica, permitiendo que un solo conjunto de señales digitales desde el exterior controle cientos de terminales de qubits.

Una representación visual de información: (Infografía)

Infografía: La Universidad de Delft y Bluefors han diseñado circuitos integrados de 22 nm capaces de funcionar en condiciones de frío extremo, específicamente por debajo de los 70 mK (milikelvin, muy cercano al cero absoluto (0 K)). Estos avanzados chips facilitan la gestión de qubits al procesar voltajes y señales directamente en la etapa criogénica, reduciendo la necesidad de múltiples conexiones externas. Gracias a su bajo consumo energético, menor a 120 μW, el sistema permite que una sola entrada digital coordine cientos de terminales de computación cuántica. Los detalles técnicos destacan una alta precisión en el control de bias y una estabilidad notable frente a las variaciones de voltaje. Esta innovación representa un paso crucial para escalar la tecnología cuántica de manera eficiente y compacta.

5.2. Arquitecturas Modulares e Interconectores Cuánticos

-. La imposibilidad de construir un chip cuántico monolítico con millones de qubits ha impulsado el diseño modular. En este paradigma, múltiples procesadores cuánticos (QPUs) se conectan mediante redes que preservan el entrelazamiento.

-. IonQ, tras adquirir Oxford Ionics y Lightsynq, ha avanzado en el uso de trampas de iones–2D con una densidad 300 veces superior a los sistemas previos, integrándolas con interconectores fotónicos basados en memoria cuántica. Estos interconectores actúan como búferes de red, aumentando la tasa de entrelazamiento entre chips hasta 50 veces, lo que hace que los clústeres cuánticos sean comercialmente viables para 2028.

6. El Camino a la Comercialización: (2025-2030)

-. El mercado de la computación cuántica ha entrado en una fase de madurez industrial. Las inversiones globales han superado los 3.700 millones de dólares en capital de riesgo solo en la primera mitad de 2025.

6.1. Hojas de Ruta: (de los Líderes del Sector)

Nota: Los principales actores han delineado trayectorias claras hacia la computación cuántica de utilidad:

- IBM: Su hoja de ruta para 2030 contempla el sistema Blue Jay de 100.000 qubits, capaz de ejecutar 1.000 millones de puertas lógicas mediante 2.000 qubits-lógicos distribuidos.

- Quantinuum: Planea alcanzar la tolerancia a fallos universal en 2030 con su sistema Apollo, demostrando ya 12 qubits lógicos en su modelo H2 actual.

- Google: Mantiene su objetivo de una computadora cuántica útil y corregida para 2029, basándose en el éxito de la supresión de errores en Willow.

- QuEra: Proyecta sistemas de tercera generación para 2026-2027 con un gran número de qubits-lógicos operando de forma continua para problemas intratables clásicamente.

6.2. Sectores con Impacto Inmediato

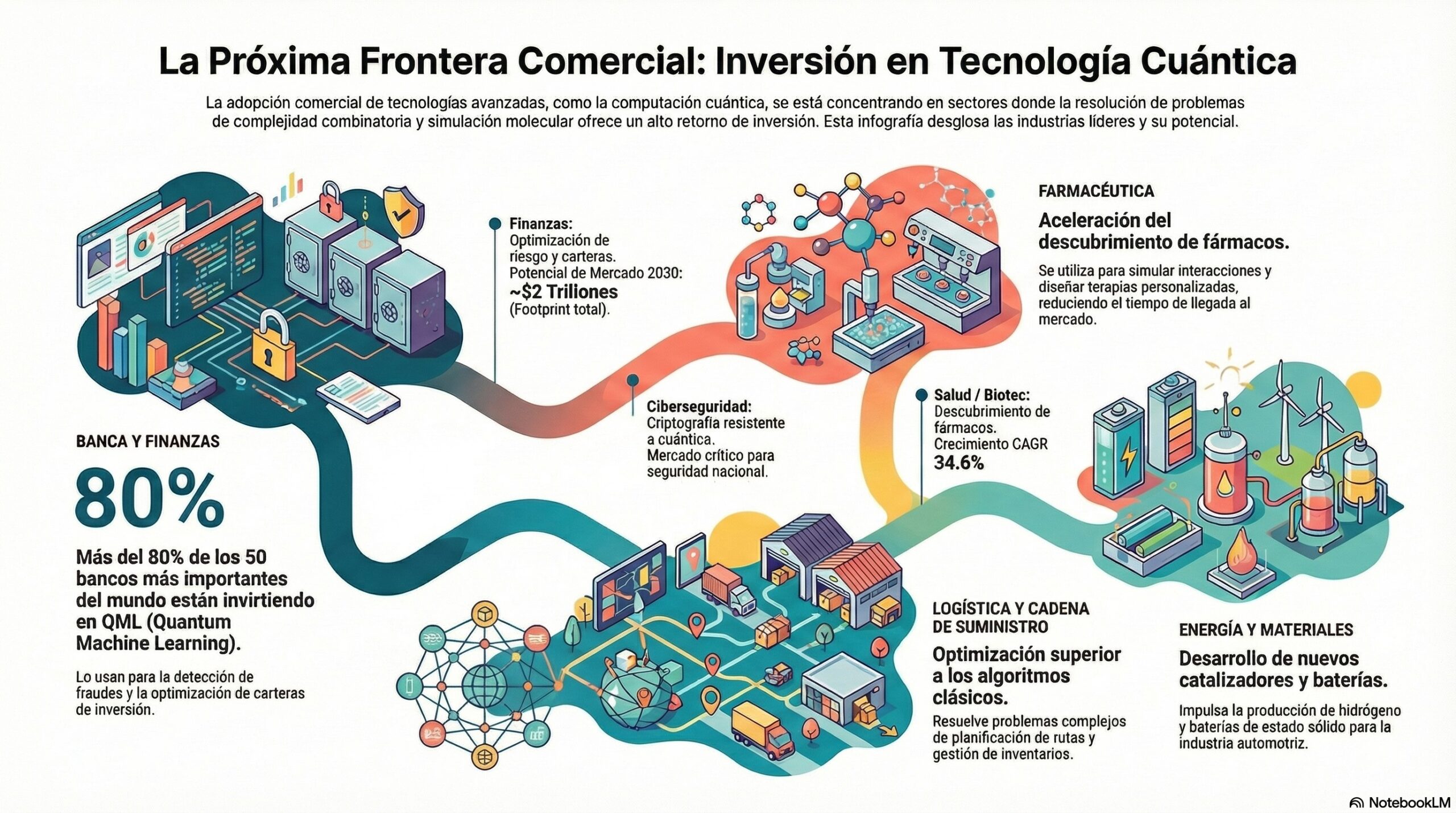

Nota: La adopción comercial se está concentrando en sectores donde la complejidad combinatoria o la simulación molecular ofrecen el mayor retorno de inversión:

- Banca y Finanzas: Más del 80% de los 50 principales bancos del mundo están invirtiendo en QML (Quantum Machine Learning) para detección de fraudes y optimización de carteras de inversión.

- Farmacéutica: Simulación de interacciones proteína-ligando y diseño de fármacos personalizados, acelerando el tiempo de llegada al mercado de nuevas terapias.

- Energía y Materiales: Desarrollo de nuevos catalizadores para la producción de hidrógeno y baterías de estado sólido, con patentes ya ganando tracción en la industria automotriz.

- Logística y Cadena de Suministro: Resolución de problemas de planificación de rutas y gestión de inventarios que superan las capacidades de los algoritmos de optimización clásicos.

Una representación visual de información: (Infografía)

Nota: Esta Infografía analiza cómo la adopción comercial de la computación cuántica se está acelerando en industrias que enfrentan desafíos lógicos complejos. En el ámbito de las finanzas, las instituciones están invirtiendo masivamente en aprendizaje automático cuántico para mejorar la seguridad contra fraudes y la gestión de activos. Los sectores de salud y biotecnología utilizan estas tecnologías para agilizar la creación de medicinas personalizadas mediante simulaciones moleculares avanzadas. Por otro lado, la industria de logística y energía busca optimizar la distribución de suministros y el desarrollo de componentes sostenibles como baterías de estado sólido. Finalmente, el documento destaca la importancia estratégica de la criptografía para proteger la infraestructura nacional frente a futuras amenazas digitales. El análisis concluye que estas innovaciones proyectan un impacto económico masivo y un crecimiento sostenido para finales de la década.

7. Implicaciones: (Geopolíticas y de Talento)

-. La computación cuántica se ha convertido en un pilar de la soberanía tecnológica. China lidera la inversión pública con un fondo de 138.000 millones de dólares para tecnologías de vanguardia, mientras que Estados Unidos mantiene su posición a través de la Iniciativa Cuántica Nacional y programas de DARPA.

7.1. El Desafío: (del Capital Humano)

-. A pesar del progreso técnico, la escasez de talento es una amenaza crítica. Se estima que para 2030 se requerirán 250.000 puestos de trabajo especializados en el sector cuántico. Deloitte advierte sobre el escenario de «Sorpresa», donde el hardware llega antes de que las organizaciones tengan la madurez operativa para utilizarlo, creando una brecha competitiva insalvable para las empresas que no comenzaron sus pilotos antes de 2025.

-. La integración de flujos de trabajo híbridos (Quantum-HPC) se perfila como la solución a corto plazo. En este modelo, los procesadores cuánticos actúan como aceleradores específicos para subrutinas computacionales complejas, mientras que el resto del programa se ejecuta en supercomputadoras clásicas. Esto requiere un middleware sofisticado, como Qiskit o Azure Quantum Elements, que pueda gestionar la distribución de tareas y la mitigación de ruido de forma transparente para el desarrollador.

Conclusiones sobre el Estado de la Cuestión:

-. La ingeniería-cuántica ha entrado en su fase de madurez industrial en 2025. Los desafíos de escalabilidad y corrección de errores, aunque formidables, han sido desglosados en problemas técnicos abordables: desde la reducción del overhead mediante códigos LDPC y cat qubits hasta la resolución del cuello de botella de cableado mediante Cryo-CMOS.

-. La evidencia experimental de Google, Quantinuum y QuEra confirma que el umbral de la computación cuántica útil está al alcance de esta década. La transición hacia sistemas con miles de qubits-lógicos para 2030 no es solo un objetivo científico, sino una necesidad económica para industrias que enfrentan límites físicos en la computación clásica. La preparación organizacional, la inversión en infraestructura modular y el desarrollo de una fuerza laboral capacitada son ahora tan críticos como la fidelidad de las propias puertas cuánticas para asegurar el éxito en la era de la computación fault-tolerant.

Resumen Ejecutivo:

-. El presente post sintetiza los avances y desafíos de la computación cuántica en el horizonte de 2025. El sector ha pivotado desde la búsqueda del número de qubits-físicos hacia la validación de la Tolerancia a Fallos (Fault-Tolerance) y la Corrección de Errores Cuánticos (QEC).

Hitos Técnicos Críticos:

- Google Willow: Primera demostración de supresión de errores exponencial con el aumento del tamaño del código de superficie, logrando una mejora de factor 2,14 por cada escalado de red.

- Quantinuum: Consolidación de 12 qubits-lógicos de alta fidelidad, superando el punto de equilibrio donde los qubits-lógicos superan el rendimiento de los físicos.

- QuEra: Logro de operación continua con 3.000 átomos neutros mediante reposición de qubits en tiempo real, eliminando la barrera de la pérdida de átomos durante cálculos largos.

Desafíos de Ingeniería y Soluciones:

- Escalabilidad de Control: La electrónica Cryo-CMOS operando a <70mK permite integrar el control de voltajes y la gestión de señales junto a los qubits, reduciendo drásticamente la carga térmica y el cableado complejo.

- Reducción de Overhead: La implementación de códigos LDPC y Cat Qubits está reduciendo los requisitos físicos de 1.000 a aproximadamente 30-100 qubits-físicos por unidad-lógica, acelerando la viabilidad económica de la tecnología.

Una representación visual de información: (Infografía)

Nota: El Infografía analiza el panorama actual de la ingeniería cuántica en 2025, destacando su transición desde la experimentación teórica hacia una fase de madurez industrial y comercial. Los avances de empresas líderes como Google, Quantinuum y QuEra demuestran que la superación de errores y la escalabilidad técnica son metas alcanzables mediante innovaciones como el control criogénico y nuevos códigos de corrección. Se proyecta que para finales de esta década existirán sistemas con miles de qubits lógicos, impulsados por la necesidad de superar las limitaciones de la informática tradicional. Por ello, el éxito futuro dependerá no solo de la precisión técnica, sino también de la preparación organizacional y la inversión en infraestructura modular. En definitiva, el enfoque estratégico ha pasado de la cantidad de hardware a la validación de una computación tolerante a fallos económicamente viable.

Perspectivas Comerciales: El mercado global proyecta un crecimiento robusto (CAGR 34.6%) hacia 2030, impulsado por aplicaciones en finanzas, biotecnología y energía. Se anticipa que para 2029-2030, las máquinas con cientos de qubits lógicos permitirán resolver problemas de simulación química y optimización logística que son actualmente inalcanzables para la supercomputación clásica. La soberanía tecnológica y el desarrollo de talento especializado se identifican como los diferenciadores estratégicos para las naciones y corporaciones en la próxima década.

Recopilando:

-. Veamos los puntos mas importantes de este post:

- Para el año 2025, la computación cuántica ha transitado de ser una disciplina teórica a una ingeniería de vanguardia enfocada en la estabilidad operativa.

- La unidad básica de información, el qubit, utiliza la superposición y el entrelazamiento para representar estados computacionales de forma exponencial.

- El principal obstáculo técnico es la decoherencia, un proceso donde el ruido ambiental degrada la información cuántica hacia un estado clásico.

- A diferencia de los sistemas clásicos, la información cuántica no se puede copiar debido al teorema de no-clonación, lo que obliga a usar redundancia mediante entrelazamiento.

- Las tasas de error del hardware actual, que oscilan entre el 0,1% y el 1%, son el gran desafío a mitigar para alcanzar la ventaja cuántica.

- Los circuitos superconductores son valorados por su velocidad de operación, pero enfrentan dificultades de escalado debido al exceso de cableado criogénico.

- La arquitectura de átomos neutros permite controlar miles de qubits de forma inalámbrica mediante el uso de pinzas ópticas impulsadas por láseres.

- Google demostró un hito histórico con su procesador Willow al lograr una supresión de errores exponencial al aumentar el tamaño del código de superficie.

- La Corrección de Errores Cuánticos (QEC) es el proceso esencial para crear qubits lógicos cuya tasa de error sea mucho menor que la de sus componentes físicos.

- Tecnologías como los códigos LDPC y Cat Qubits están reduciendo el exceso de qubits físicos necesarios de 1.000 a solo 30-100 por cada qubit lógico.

- El uso de electrónica Cryo-CMOS operando a menos de 70 mK (milikelvin) permite simplificar la arquitectura cuántica al integrar el control directamente en la etapa criogénica.

- La adopción comercial se acelera en sectores como la banca y la farmacéutica, donde se busca optimizar carteras y diseñar fármacos personalizados.

- La disciplina se ha convertido en un pilar de la soberanía tecnológica, con inversiones públicas masivas por parte de potencias como China y Estados Unidos.

- Existe una preocupación crítica por la escasez de talento especializado, estimándose una necesidad de 250.000 profesionales para finales de la década.

- El futuro inmediato se orienta hacia modelos híbridos (Quantum-HPC), donde los procesadores cuánticos funcionan como aceleradores para tareas de alta complejidad.

- Para entender mejor esta transición tecnológica, imagina que pasar de los qubits frágiles a ordenadores tolerantes a fallos es como intentar construir un castillo de naipes en medio de una tormenta: la ingeniería actual no solo busca hacer las cartas más pesadas (qubits físicos), sino construir un escudo protector (corrección de errores) para que la estructura permanezca en pie sin importar el viento.

- Referencias: moreluz.entorno

- Referencias: Cisco

- Referencias: NotebookLM