Prologo: La introducción del procesador Willow de Google representa un punto de inflexión crítico al demostrar empíricamente que la corrección de errores cuánticos es viable y escalable. Esta arquitectura de 105 qubits físicos de tipo transmon se fundamenta en los principios de superposición y entrelazamiento para operar en un espacio de Hilbert de inmensa dimensionalidad. A través de la implementación del código de superficie, el sistema ha logrado una supresión de errores exponencial, permitiendo que un qubit lógico posea una vida útil superior a la de sus componentes físicos. Willow ha alcanzado hitos sin precedentes, realizando en cinco minutos cálculos de muestreo de circuitos aleatorios que tomarían (10 elevado 25) años a las supercomputadoras clásicas más potentes. En el ecosistema global, este avance compite con las hojas de ruta de IBM y Microsoft, quienes exploran códigos qLDPC y qubits topológicos para alcanzar la tolerancia a fallos completa. Finalmente, aunque persisten desafíos como el ruido provocado por los rayos cósmicos, el éxito de Willow acelera la transición hacia aplicaciones prácticas en la ciencia de materiales y el descubrimiento de fármacos.

Indice-Contenido:

- Fundamentos y Definición de Conceptos en Computación Cuántica

- Arquitectura Física y Especificaciones Técnicas del Chip Willow

- Teoría y Práctica de la Corrección de Errores Cuánticos (QEC)

- El Hito del Muestreo de Circuitos Aleatorios (RCS)

- Algoritmo Quantum Echoes: Ventaja Cuántica Verificable

- Estado de la Cuestión: Panorama Competitivo Global

- Aplicaciones Industriales y Transformación Sectorial

- Desafíos Técnicos y Críticas al Modelo de Google

- Conclusión sobre el Estado de la Cuestión

Resumen de Audio:

Arquitectura de Procesamiento Cuántico: Willow

-. El desarrollo de la computación cuántica ha trascendido la fase de la mera especulación teórica para convertirse en un campo de ingeniería de precisión donde la manipulación de la materia a escala subatómica permite el procesamiento de información en regímenes inalcanzables para la computación clásica. La introducción del procesador Willow por parte de Google Quantum AI representa un punto de inflexión crítico en esta trayectoria, no solo por el aumento en el conteo de qubits-físicos, sino por la demostración empírica de que la corrección de errores cuánticos es viable y escalable. Este post analiza detalladamente la arquitectura de Willow, los principios de la corrección de errores por código de superficie, los hitos de ventaja cuántica verificable y el estado actual de la industria global.

1. Fundamentos y Definición de Conceptos en CC:

-. Para comprender la magnitud de los avances representados por el chip Willow, es imperativo establecer una base conceptual sólida sobre los principios que rigen estos sistemas. La computación cuántica no es una extensión de la computación clásica, sino un paradigma basado en las leyes de la mecánica cuántica que opera en un espacio de Hilbert cuya dimensionalidad crece exponencialmente con el número de unidades de información o qubits.

1.1. El Qubit y la Superposición Lineal:

. A diferencia de un bit-clásico, que se encuentra restringido a los estados discretos 0 o 1, un qubit es un sistema mecánico cuántico de dos niveles que puede existir en una superposición lineal de ambos estados, proporcionando la base para el paralelismo cuántico masivo.

1.2. Entrelazamiento y Correlaciones No Locales:

-. El entrelazamiento-cuántico es un fenómeno en el cual los estados de dos o más qubits se vuelven intrínsecamente vinculados, de tal manera que la descripción de un qubit individual es imposible sin considerar el estado del resto del sistema. En términos matemáticos, un estado entrelazado no puede factorizarse como el producto de estados individuales. Esta característica es esencial para la ejecución de puertas lógicas de dos qubits, como la puerta de fase controlada (CZ) o la puerta iSWAP, que son los bloques de construcción de los circuitos cuánticos complejos ejecutados en Willow.

1.3. Decoherencia y el Problema del Ruido:

-. El mayor obstáculo para la computación cuántica es la decoherencia, el proceso mediante el cual un sistema cuántico pierde su información debido a la interacción no deseada con el entorno. Las fluctuaciones térmicas, la radiación electromagnética e incluso los rayos cósmicos pueden provocar errores de inversión de bit (bit-flip) o de inversión de fase (phase-flip). El tiempo de relajación T1 es una métrica crítica que define la longevidad de un qubit antes de que este pierda su energía y regrese al estado fundamental |0⟩. En el chip Willow, se han logrado mejoras significativas en este parámetro, alcanzando promedios de hasta 98-ms mediante técnicas avanzadas de fabricación.

Una representación visual de información: (Infografía)

La Infografía: describe los principios fundamentales que sustentan la computación cuántica, utilizando el innovador chip Willow como referencia tecnológica. Explica que esta tecnología se aleja de la informática tradicional al emplear qubits, los cuales permiten la superposición de múltiples estados y el entrelazamiento para realizar procesos masivos de forma simultánea. Asimismo, la fuente aborda los desafíos técnicos críticos, específicamente la decoherencia y el ruido ambiental que pueden comprometer la integridad de los datos. Se destaca la importancia de mejorar el tiempo de relajación para asegurar la estabilidad del sistema frente a interferencias externas. En conclusión, el contenido ofrece una visión técnica sobre cómo estos conceptos físicos permiten el desarrollo de circuitos cuánticos altamente complejos y eficientes.

2. Arquitectura Física y Especificaciones Técnicas del Chip Willow

-. El procesador Willow representa la culminación de múltiples generaciones de investigación en circuitos superconductores. Como sucesor del chip Sycamore, Willow ha sido diseñado con un enfoque primordial en la corrección de errores y la escalabilidad de las operaciones lógicas.

2.1. Diseño de Qubits Superconductores y Transmones

– . Willow utiliza qubits de tipo transmon, que son osciladores anarmónicos superconductores compuestos por un condensador y una unión Josephson. La anarmonicidad de la unión Josephson permite aislar los dos niveles de energía más bajos para funcionar como un qubit, evitando transiciones a niveles superiores. La fabricación de estos dispositivos se realiza en Santa Barbara, California, utilizando técnicas de litografía de alta precisión y procesos de optimización de parámetros de circuito.

2.2. Conectividad y Topología de la Red

-. La arquitectura de Willow se basa en una rejilla cuadrada de 105 qubits-físicos. Esta topología es fundamental para implementar el código de superficie (surface code), un esquema de corrección de errores que requiere una conectividad local robusta. La conectividad promedio de Willow es de 3.47, con configuraciones típicas de 4 vías que facilitan la medición de los estabilizadores necesarios para identificar errores sin destruir la información cuántica almacenada.

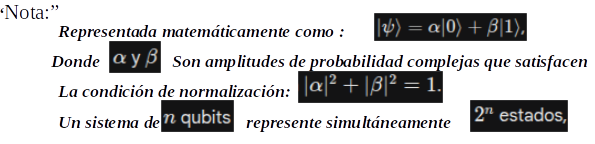

Una representación visual de información: (Infografía)

Esta Infografía: detalla las especificaciones técnicas de Willow, una arquitectura de computación cuántica compuesta por 105 qubits físicos organizados en una rejilla cuadrada. El diseño se centra en la implementación de un código de superficie, utilizando una conectividad robusta para detectar fallos sin comprometer los datos almacenados. El documento incluye métricas críticas sobre el rendimiento del sistema, destacando el uso de qubits transmon superconductores con tiempos de coherencia que alcanzan los 98 microsegundos. Además, se presentan datos precisos sobre las bajas tasas de error en las puertas lógicas y el tiempo de ciclo necesario para la corrección de errores. En conjunto, la información describe un hardware avanzado diseñado para lograr una computación cuántica estable y eficiente.

2.3. Ingeniería de la Relación de Participación

-. Uno de los avances técnicos más discretos pero impactantes en Willow es la «ingeniería de la relación de participación» (participation ratio engineering). Esta técnica consiste en diseñar cuidadosamente la distribución de los campos electromagnéticos dentro del chip para minimizar la cantidad de energía que interactúa con las superficies y las interfaces materiales, donde las pérdidas dieléctricas son más pronunciadas. Al reducir esta participación, se ha logrado extender los tiempos de coherencia de manera drástica en comparación con la arquitectura Sycamore, pasando de 20us a valores cercanos a los 100us.

3. Teoría y Práctica de la Corrección de Errores Cuánticos (QEC)

-. El propósito fundamental de Willow es demostrar que es posible construir computadores cuánticos que puedan escalar su fiabilidad. Tradicionalmente, aumentar el número de qubits en un sistema incrementaba la probabilidad total de error de manera insostenible. Sin embargo, mediante la corrección de errores cuánticos (QEC), es posible agrupar múltiples qubits-físicos en un único «qubit-lógico» que es más robusto que sus componentes individuales.

3.1. El Código de Superficie y el Umbral de Error

-. El código de superficie implementado en Willow organiza los qubits-físicos en una red bidimensional donde se realizan mediciones repetitivas de operadores de paridad conocidos como estabilizadores. Estos estabilizadores detectan errores de X (bit-flip) y Z (phase-flip) sin observar directamente el estado del qubit de datos, preservando así la superposición.

-. El concepto de «umbral» es vital: si la tasa de error de los qubits-físicos está por debajo de un nivel crítico (aproximadamente 1%), añadir más qubits-físicos para formar un qubit-lógico reduce la tasa de error lógica de manera exponencial. Willow es el primer procesador en demostrar este comportamiento de manera inequívoca. Al escalar de una red de 3X3 a una de 7X7:

![]()

3.2. Resultados de Supresión Exponencial

-. La experimentación con Willow ha permitido alcanzar hitos que se perseguían desde hace casi 30 años. Un qubit-lógico de distancia, que utiliza 101 qubits-físicos, ha demostrado una tasa de error por ciclo de solo 0.143%. Lo más impresionante es que este qubit-lógico posee una vida útil que es más del doble de la de su mejor componente físico constituyente, superando el punto de «break-even» por un factor de 2.4 +- 0.3.

3.3. Decodificación en Tiempo Real y Latencia

-. Para que un computador cuántico sea útil, los errores deben ser detectados y corregidos en tiempo real. Google ha integrado en Willow un sistema de decodificación basado en redes neuronales y algoritmos de grafos que procesa la información de los estabilizadores mientras el sistema sigue operando. Se ha reportado una latencia de decodificación promedio de 63us para códigos de distancia-5, un logro significativo considerando que los ciclos de corrección ocurren cada 1.1us Sin embargo, la gestión de esta latencia sigue siendo un desafío de ingeniería para sistemas con miles de qubits-lógicos.

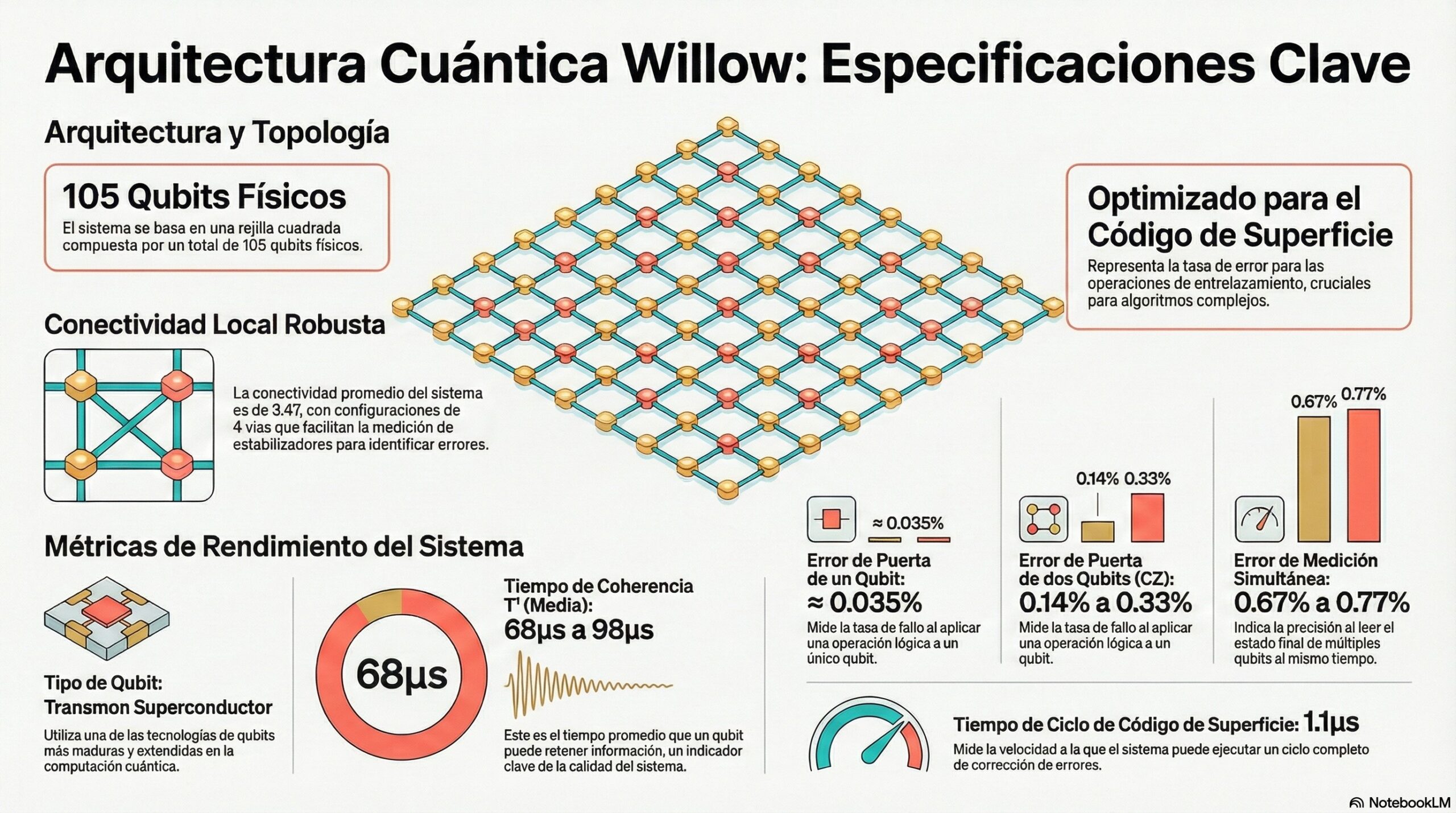

Una representación visual de información: (Infografía)

Nota: El procesador Willow de Google representa un hito histórico al demostrar que es posible reducir los errores de computación mediante la corrección de errores cuánticos (QEC). A través del uso de un código de superficie, el sistema agrupa múltiples unidades físicas en un qubit lógico que es significativamente más resistente y duradero que sus componentes individuales. El estudio destaca que, al aumentar la escala de la red de qubits, la probabilidad de fallo disminuye de forma exponencial, superando finalmente el punto de equilibrio operativo. Para gestionar estos fallos, la tecnología emplea decodificación en tiempo real basada en redes neuronales, procesando datos a velocidades asombrosas. Estos resultados confirman que la computación cuántica puede ser escalable y fiable, resolviendo desafíos técnicos que persistieron durante casi tres décadas.

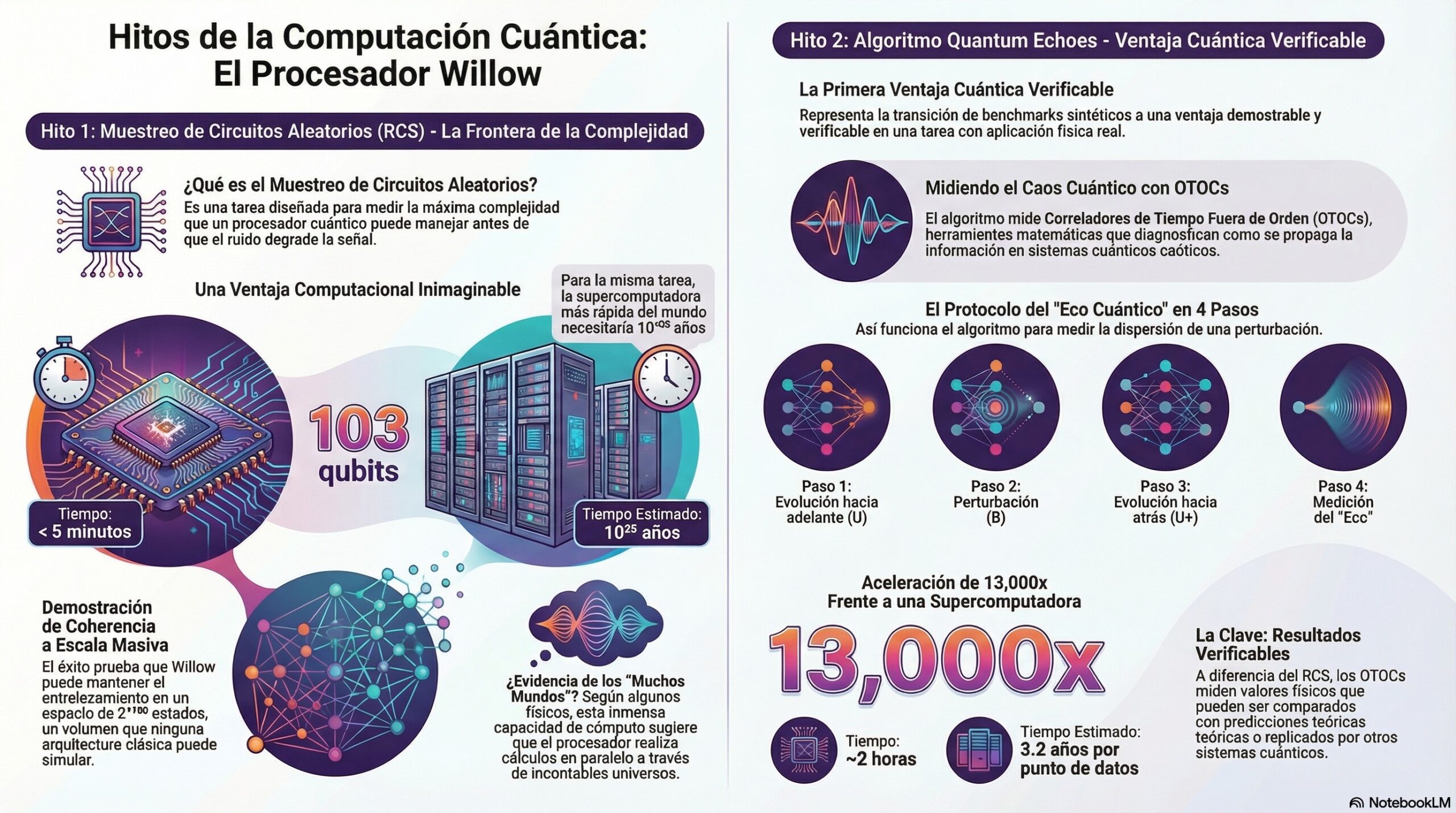

4. El Hito del Muestreo de Circuitos Aleatorios (RCS)

-. El muestreo de circuitos aleatorios es una tarea de evaluación comparativa diseñada para medir la complejidad máxima de un estado cuántico que un hardware puede procesar antes de que el ruido degrade la señal. Willow ha elevado este listón a niveles que desafían la capacidad de las máquinas clásicas más potentes.

4.1. Complejidad Computacional vs. Simulación Clásica

-. En las pruebas realizadas con el «Chip 2» de Willow, optimizado para fidelidad operativa, se ejecutaron circuitos aleatorios de profundidad 40 utilizando 103 qubits. Willow completó este cálculo en menos de 5 minutos. Según las estimaciones del equipo de Google Quantum AI, realizar la misma tarea en la supercomputadora más rápida del mundo hoy en día requeriría 10 (elevado a) 25 años, una cantidad de tiempo que excede vastamente la edad del universo.

-. Este resultado no implica que el computador cuántico sea útil para todas las tareas, ya que el RCS es un problema sintético. Su importancia radica en demostrar que el procesador Willow puede mantener la coherencia y el entrelazamiento en un espacio de Hilbert de dimensiones 2 (elevado a)103, un volumen de estados que ninguna arquitectura clásica puede aspirar a representar o simular con precisión.

4.2. La Controversia del Multiverso

-. El fundador de Google Quantum AI, Hartmut Neven, ha señalado que el éxito de Willow en estas tareas de complejidad masiva presta credibilidad a la interpretación de los «muchos mundos» de la mecánica cuántica. Según este argumento, propuesto originalmente por David Deutsch, la inmensa capacidad de cómputo de un procesador cuántico proviene de su capacidad para realizar cálculos en paralelo a través de un número casi infinito de universos paralelos. Aunque esta es una interpretación filosófica disputada por muchos físicos, subraya la naturaleza radicalmente distinta del procesamiento de información cuántica frente al clásico.

5. Algoritmo Quantum Echoes: (Ventaja Cuántica Verificable)

-. Un avance fundamental presentado en octubre de 2025 es el algoritmo de «Quantum Echoes«, el cual demuestra la primera ventaja cuántica verificable en hardware para una tarea algorítmica específica. Este experimento marca la transición desde los benchmarks sintéticos hacia aplicaciones con relevancia física directa.

5.1. Funcionamiento de los OTOC: (Correladores de Tiempo Fuera de Orden)

-. El algoritmo se centra en medir los Correladores de Tiempo Fuera de Orden (OTOCs), que son herramientas matemáticas utilizadas para diagnosticar el caos cuántico y la propagación de información en sistemas de muchas partículas. El protocolo funciona de la siguiente manera:

- Evolución hacia adelante (U): El sistema de qubits evoluciona bajo un Hamiltoniano que genera un estado altamente entrelazado y caótico.

- Perturbación (B): Se introduce una pequeña perturbación en un único qubit, equivalente a un «efecto mariposa» cuántico.

- Evolución hacia atrás (U+): Se invierte el tiempo cuántico, aplicando la operación inversa del Hamiltoniano original.

- Medición: Se observa el estado final. Si no hubiera perturbación, el sistema volvería a su estado inicial. La diferencia medida (el «eco«) revela cómo la perturbación inicial se ha dispersado y revuelto a través de las correlaciones del sistema.

5.2. Resultados de la Aceleración de 13,000x

-. En experimentos que utilizaron 65 de los 105 qubits de Willow, se midieron OTOCs de segundo orden que mostraron efectos de interferencia de muchos cuerpos. Esta tarea tomó aproximadamente 2 horas en el chip Willow. En contraste, se estima que la supercomputadora Frontier (es una supercomputadora exaescala de Hewlett Packard Enterprise (HPE) ubicada en el Laboratorio Nacional de Oak Ridge (Tennessee, EE.UU.), tardaría 3.2 años en calcular cada punto de datos, lo que resulta en una ventaja de velocidad de 13,000 veces

-. Lo crucial es que este resultado es «verificable«: a diferencia del RCS, donde la verificación clásica es exponencialmente difícil, los OTOCs miden valores de expectativa física (como la magnetización) que pueden compararse con predicciones teóricas en regímenes de menor complejidad y luego extrapolarse con confianza, o bien ser replicados por otros hardware cuánticos de alta fidelidad.

Una representación visual de información: (Infografía)

Nota: El procesador cuántico Willow ha logrado hitos históricos al superar drásticamente la capacidad de las supercomputadoras clásicas más avanzadas del mundo. Mediante el muestreo de circuitos aleatorios, este chip demostró una estabilidad sin precedentes, completando en pocos minutos tareas que a una máquina tradicional le tomarían eones. Además, el desarrollo del algoritmo Quantum Echoes ha permitido medir el caos cuántico con una velocidad trece mil veces superior a la tecnología convencional. Este avance no solo es una proeza técnica, sino que ofrece una ventaja cuántica verificable con aplicaciones directas en la física experimental. Finalmente, estos resultados impulsan debates científicos profundos sobre la naturaleza de la realidad y la posible existencia de universos paralelos para explicar tal poder de procesamiento.

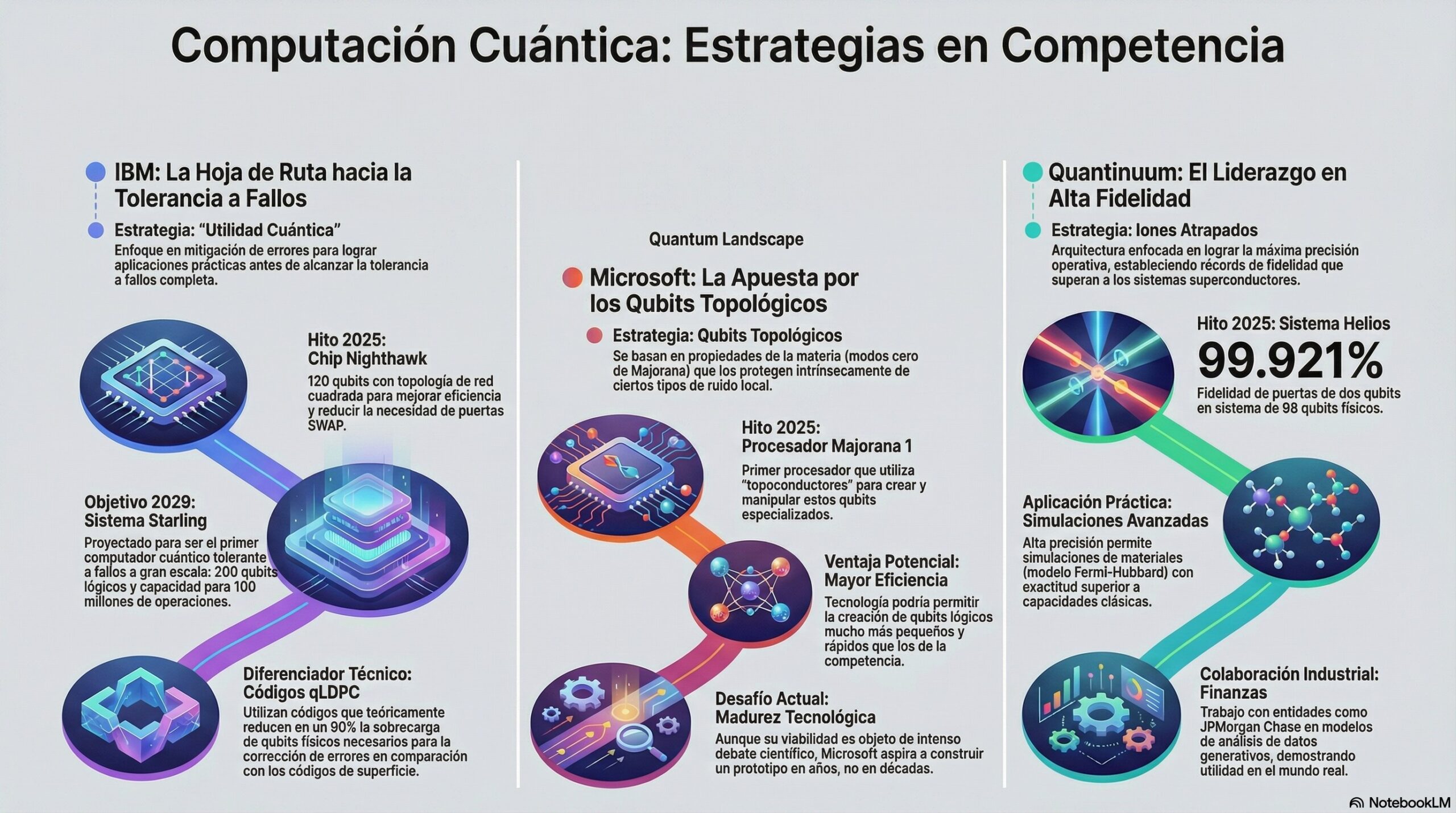

6. Estado de la Cuestión: (Panorama Competitivo Global)

-. La carrera por la computación cuántica no es un esfuerzo solitario de Google. Otros actores industriales están persiguiendo estrategias divergentes en hardware y corrección de errores, lo que enriquece el ecosistema pero también genera debates sobre cuál será el estándar tecnológico dominante.

6.1. IBM y la Hoja de Ruta hacia Starling

-. IBM ha mantenido una cadencia constante en la publicación de sus planes de desarrollo, centrando su estrategia actual en la «utilidad cuántica» y la mitigación de errores antes de alcanzar la tolerancia a fallos completa. En 2025, IBM presentó el chip Nighthawk de 120 qubits, que utiliza una topología de red cuadrada para mejorar la eficiencia de los circuitos al reducir la necesidad de puertas SWAP.

-. La meta de IBM para 2029 es el sistema Starling, proyectado para ser el primer computador cuántico tolerante a fallos a gran escala, capaz de ejecutar 100 millones de operaciones sobre 200 qubits-lógicos. La diferencia fundamental con el enfoque de Google radica en el uso de códigos qLDPC (Quantum Low-Density Parity Check), que teóricamente permiten una reducción del 90% en la sobrecarga de qubits-físicos necesarios para la corrección de errores en comparación con los códigos de superficie.

6.2. Microsoft y los Qubits Topológicos: (El Proyecto Majorana)

-. Microsoft ha apostado por una arquitectura radicalmente distinta basada en qubits-topológicos. En febrero de 2025, anunciaron el procesador Majorana-1, el cual utiliza «topoconductores» diseñados para crear y manipular modos cero de Majorana. Estos qubits se basan en propiedades topológicas de la materia que los protegen intrínsecamente de ciertos tipos de ruido local, lo que podría permitir qubits-lógicos mucho más pequeños y rápidos.

-. Aunque la madurez de esta tecnología aún es motivo de debate científico intenso debido a la dificultad de distinguir los modos de Majorana de otros estados triviales como los de Andreev, Microsoft afirma estar en camino de construir un prototipo tolerante a fallos en años, no décadas, bajo el programa US2QC de DARPA.

6.3. Quantinuum y la Alta Fidelidad de Iones Atrapados

-. Quantinuum, mediante su arquitectura de iones atrapados, ha logrado establecer récords de fidelidad operativa que superan a los sistemas superconductores actuales. Su sistema Helios, lanzado a finales de 2025, cuenta con 98 qubits-físicos con una fidelidad de puertas de dos qubits de 99.921%. Esta precisión ha permitido a Quantinuum realizar simulaciones de materiales superconductores (modelo de Fermi-Hubbard) con una exactitud que supera las capacidades clásicas actuales, colaborando con instituciones financieras como JPMorgan Chase en modelos de análisis de datos generativos.

Una representación visual de información: (Infografía)

Esta (Infografía: ofrece un panorama detallado sobre la competencia global en el sector de la computación cuántica, destacando las diversas estrategias de los líderes de la industria. IBM se enfoca en la utilidad práctica y la reducción de errores mediante códigos avanzados, con el ambicioso objetivo de lograr la tolerancia a fallos para el año 2029. Por su parte, Microsoft desarrolla una arquitectura única basada en qubits topológicos, buscando una protección intrínseca contra el ruido ambiental para acelerar el procesamiento. Mientras tanto, Quantinuum lidera en precisión utilizando iones atrapados, logrando niveles de fidelidad que ya superan las capacidades de la computación tradicional en simulaciones complejas. En conjunto, el documento revela un ecosistema en rápida evolución donde diferentes tecnologías de hardware compiten por establecer el estándar definitivo del futuro cuántico.

7. Aplicaciones Industriales y Transformación Sectorial

-. El avance de Willow hacia la corrección de errores efectiva ha comenzado a materializar casos de uso que anteriormente se consideraban puramente teóricos. La capacidad de simular la naturaleza en su propio lenguaje (el de la mecánica cuántica) tiene implicaciones profundas para múltiples sectores.

7.1. Ciencia de Materiales y Energía

-. Una aplicación destacada es la creación de una «regla molecular» cuántica mediante el algoritmo Quantum Echoes. En colaboración con la Universidad de California, Berkeley, Google demostró que es posible utilizar el chip Willow para estudiar la geometría molecular de sistemas orgánicos de hasta 28 átomos, revelando información estructural que los métodos de Resonancia Magnética Nuclear (NMR) tradicionales no pueden capturar. Esto es vital para el desarrollo de nuevos catalizadores para la producción de fertilizantes (proceso Haber-Bosch), la búsqueda de materiales superconductores a temperatura ambiente y la optimización de celdas de combustible para la industria automotriz.

7.2. Descubrimiento de Fármacos y Biología

-. La precisión alcanzada por Willow permite modelar cómo las moléculas pequeñas se unen a proteínas específicas, un proceso crítico en el diseño de nuevos medicamentos. Al poder simular las interacciones electrónicas y los efectos de interferencia cuántica en el centro activo de una enzima, los investigadores pueden reducir drásticamente el tiempo de desarrollo de fármacos, pasando de años de pruebas de ensayo y error a simulaciones computacionales exactas.

7.3. Criptografía y Ciberseguridad

-. Aunque el chip Willow no es capaz de ejecutar el algoritmo de Shor para romper el cifrado RSA actual (una tarea que requeriría miles de qubits-lógicos estables), su progreso ha enviado una señal clara a las organizaciones de seguridad. La velocidad de innovación sugiere que el «día Q» (el momento en que el cifrado tradicional se vuelva obsoleto) podría ocurrir en un horizonte de 10 a 15 años. Por ello, se recomienda la migración inmediata a estándares de criptografía post-cuántica (PQC) para proteger los datos con ciclos de vida largos.

8. Desafíos Técnicos y Críticas al Modelo de Google

-. A pesar de los éxitos rotundos de Willow, la comunidad científica mantiene una postura cautelosa respecto a los obstáculos que aún deben superarse.

8.1. La Escala del Hardware y el Consumo de Recursos

-. Para alcanzar una utilidad comercial generalizada, se estima que se necesitarán millones de qubits-físicos para sostener miles de qubits-lógicos. Con Willow operando a 105 qubits, el salto hacia el millón representa un desafío logístico, térmico y de control sin precedentes. La potencia de refrigeración necesaria para mantener tales redes a temperaturas de milikelvin y la complejidad de los cables de control por radiofrecuencia son barreras físicas activas.

8.2. El Suelo de Error y los Rayos Cósmicos

-. Un hallazgo inquietante reportado por Google es que, incluso con códigos de corrección avanzados, existe un «suelo de error» que no disminuye con el aumento del tamaño del código. Se ha identificado que eventos externos, como los impactos de rayos cósmicos, generan errores correlacionados a gran escala que pueden abrumar la capacidad de corrección del código de superficie. Mitigar estos eventos requerirá blindajes radiactivos masivos o el desarrollo de nuevos códigos que puedan manejar errores no locales.

9. Conclusión sobre el Estado de la Cuestión

-. El procesador Willow ha demostrado que la computación cuántica ha entrado en una fase de madurez donde la corrección de errores ya no es una hipótesis, sino una realidad de ingeniería. Con una supresión de errores exponencial y la capacidad de ejecutar algoritmos verificables 13,000 veces más rápido que las supercomputadoras clásicas, Willow se posiciona como el estándar de oro actual en la carrera cuántica. Mientras que competidores como IBM y Microsoft avanzan con arquitecturas alternativas promisorias, el enfoque de Google en el código de superficie y la fidelidad operativa de los transmones ha proporcionado los primeros resultados tangibles de una ventaja cuántica con potencial de aplicación industrial.

Una representación visual de información: (Infografía)

Esta Infografía: examina el procesador Willow, un innovador chip de Google Quantum AI que cuenta con 105 qubits físicos y redefine la computación moderna. El documento destaca un logro histórico en la corrección de errores, demostrando que es posible extender la vida útil de los datos cuánticos mediante estructuras de mayor escala. Gracias a su potencia, esta tecnología supera drásticamente a las supercomputadoras clásicas, resolviendo problemas complejos en minutos que de otro modo tardarían milenios. Además, el texto detalla aplicaciones prácticas en la ciencia de materiales y el diseño de fármacos, posicionando a Google frente a competidores como IBM y Microsoft. Finalmente, se analizan los desafíos técnicos pendientes, como la interferencia externa, proyectando una transición de hasta quince años hacia sistemas totalmente fiables.

Resumen Ejecutivo: El presente post analiza el impacto y las especificaciones técnicas del chip Willow de Google Quantum AI, un procesador de 105 qubits-físicos que marca el primer éxito histórico en la corrección de errores cuánticos escalable. A través de esta inmersión profunda en su arquitectura, identificamos las siguientes conclusiones clave:

- Hito de Corrección de Errores: Willow es el primer chip que demuestra que el rendimiento de un qubit-lógico mejora exponencialmente al aumentar el número de qubits-físicos constituyentes. Un qubit-lógico de distancia 7 ha mostrado una vida útil 2.4 veces superior a la de los mejores qubits-físicos del sistema.

- Rendimiento en Benchmarking: En tareas de muestreo de circuitos aleatorios (RCS), Willow ha ejecutado cálculos en 5 minutos que tomarían 10 elevado 25 años a las supercomputadoras-clásicas más avanzadas, demostrando un dominio absoluto en el manejo de estados cuánticos complejos de alta dimensionalidad.

- Ventaja Cuántica Verificable: Mediante el algoritmo de «Quantum Echoes«, el hardware ha demostrado una aceleración de 13,000 veces sobre la supercomputadora-Frontier en la medición de correladores de tiempo fuera de orden (OTOCs). Este avance es fundamental por su naturaleza verificable y su aplicación directa en el aprendizaje de Hamiltonianos y la ciencia de materiales.

- Aplicación Práctica Inmediata: Se ha validado el uso de Willow como una «regla molecular» capaz de mejorar la precisión de la espectroscopia NMR para determinar la geometría de moléculas orgánicas, abriendo caminos críticos para el diseño de fármacos y nuevos materiales químicos.

- Panorama Global y Roadmaps: Mientras Google consolida su liderazgo en circuitos superconductores con códigos de superficie, IBM avanza hacia 2029 con el sistema Starling y códigos qLDPC, y Microsoft busca la disrupción mediante qubits topológicos de Majorana. El mercado cuántico está en una fase de expansión agresiva con inversiones que superan los 3,700 millones de dólares en 2025.

- Desafíos Futuros: A pesar de los logros, persisten retos en la latencia de decodificación en tiempo real y en la mitigación de errores correlacionados causados por factores externos como los rayos cósmicos. La industria debe prepararse para una transición de 10 a 15 años hacia sistemas tolerantes a fallos de escala completa.

Recopilando:

-. Veamos los puntos mas importantes de este post:

- El procesador Willow de Google representa un punto de inflexión al demostrar empíricamente que la corrección de errores cuánticos es viable y escalable.

- Esta arquitectura se fundamenta en 105 qubits físicos de tipo transmon, que operan mediante los principios de superposición y entrelazamiento.

- A través de la implementación del código de superficie, el sistema organiza los qubits en una rejilla cuadrada para detectar fallos sin destruir la información almacenada.

- Willow ha logrado crear un qubit lógico con una vida útil que supera por un factor de 2.4 a la de sus mejores componentes físicos individuales.

- El chip alcanzó un hito de rendimiento al realizar en solo cinco minutos cálculos de muestreo de circuitos aleatorios que a una supercomputadora clásica le tomarían 10^25 años.

- Mediante la «ingeniería de la relación de participación», se ha logrado extender los tiempos de coherencia de los qubits hasta alcanzar promedios de 98 microsegundos.

- El algoritmo Quantum Echoes ha permitido demostrar una ventaja cuántica verificable, con una aceleración de 13,000 veces respecto a la supercomputadora Frontier.

- Dicho algoritmo mide los Correladores de Tiempo Fuera de Orden (OTOCs) para diagnosticar el caos cuántico y la propagación de información en sistemas complejos.

- En el ámbito de la ciencia de materiales, Willow funciona como una «regla molecular» capaz de determinar la geometría de sistemas orgánicos de hasta 28 átomos.

- La precisión del procesador permite modelar interacciones electrónicas críticas para reducir drásticamente el tiempo de descubrimiento de nuevos fármacos.

- En la competencia global, IBM proyecta para 2029 el sistema Starling, el cual utilizará códigos qLDPC para reducir la sobrecarga de qubits físicos.

- Por su parte, Microsoft desarrolla qubits topológicos bajo el Proyecto Majorana, buscando una protección intrínseca contra el ruido ambiental.

- Un hallazgo técnico relevante es la existencia de un «suelo de error» inamovible causado por factores externos como los rayos cósmicos.

- La gestión de la latencia de decodificación en tiempo real sigue siendo un desafío, con ciclos de corrección que ocurren cada 1.1 microsegundos.

- Se estima que la industria tardará entre 10 y 15 años en alcanzar una tolerancia a fallos completa que haga obsoleto el cifrado tradicional

- Referencias: moreluz.entorno

- Referencias: Cisco

- Referencias: NotebookLM