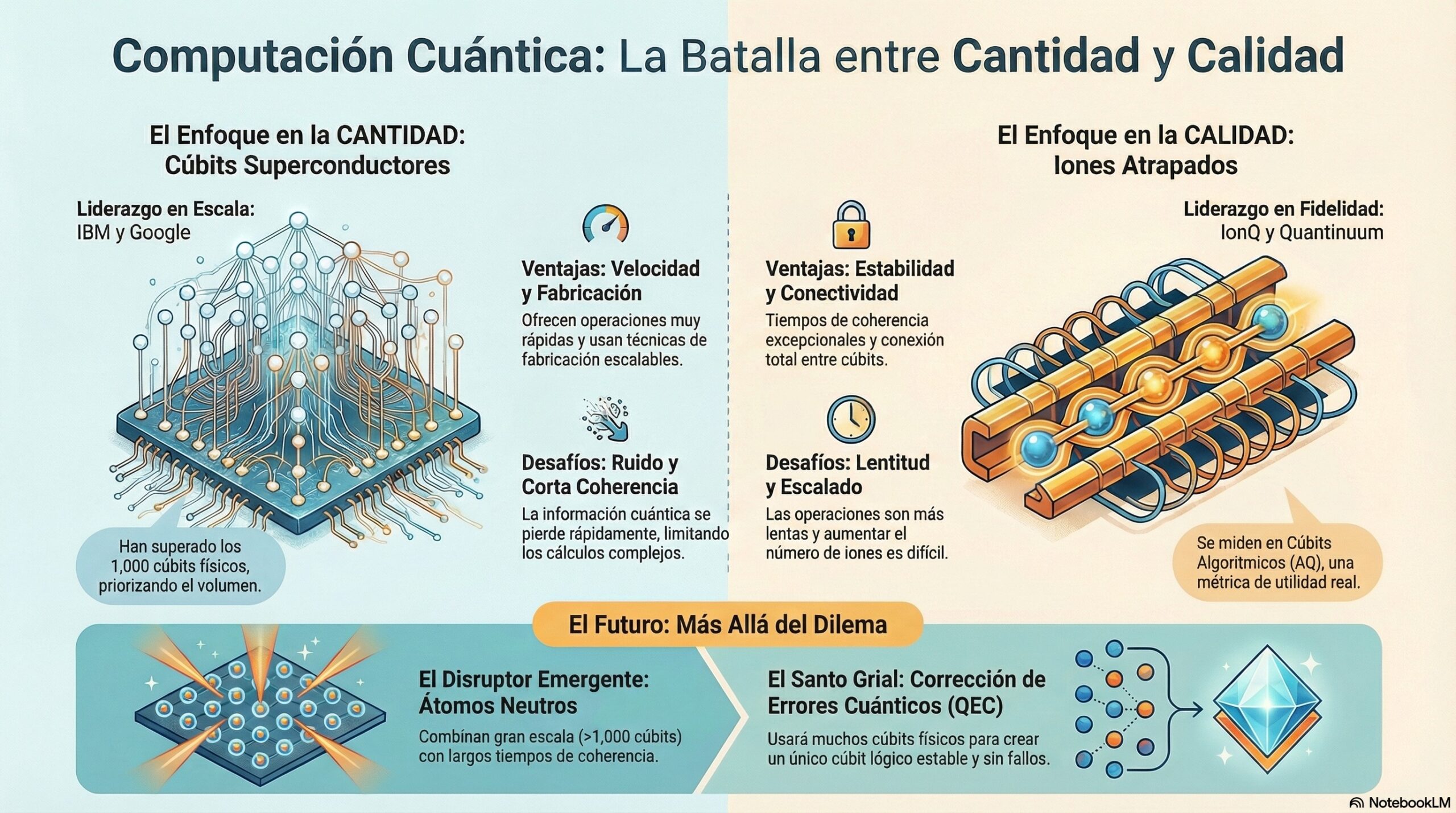

Prologo: El estado actual de la computación cuántica se describe como una «adolescencia de la ingeniería,» cuyo propósito es resolver problemas que hoy son literalmente imposibles para los ordenadores normales,. Esta etapa se caracteriza por un conflicto central entre construir más cubits (cantidad) o construir mejores cubits (calidad), lo cual ha enfrentado a tecnologías como los superconductores y los iones atrapados,. Aunque el recuento de cubits superó los 1000 en el enfoque de volumen, la realidad es que esta métrica puede ser una «métrica de vanidad» si el sistema es demasiado ruidoso,,. De hecho, el pivote estratégico de IBM hacia procesadores diseñados para reducir el ruido confirma que la calidad es el verdadero cuello de botella en la era NISQ (computación cuántica ruidosa de escala intermedia),,. Adicionalmente, los átomos neutros han surgido como un posible disruptor, combinando la escala de más de 1000 cubits con tiempos de coherencia potencialmente mucho más largos,. No obstante, el «Santo Grial» para salir de esta fragilidad es la corrección de errores cuánticos, que usará muchos cubits físicos imperfectos para codificar un único cubit lógico robusto y estable.

Indice-Contenido:

- Fundamentos y Propósito: (Más allá de los Ceros y Unos)

- El Estado Actual: (La Era NISQ)

- Plataformas de Hardware (Líderes)

- Métricas Reales: (Qubits Estables y Disponibilidad Comercial)

Resumen de Audio:

Arquitectura-técnica-CC: (física subyacente), (realidad comercial actual)

-. Este Post analiza un informe técnico sobre el estado actual de la computación-cuántica (CC), identificando esta fase como la «adolescencia» ruidosa o era NISQ, donde el objetivo es resolver problemas que hoy son inabordables para la computación–clásica. El conflicto central se centra en la disyuntiva entre la cantidad de cúbits–físicos (liderada por IBM) y la calidad o fidelidad operativa (priorizada por empresas de iones atrapados), concluyendo que la métrica crucial es el número de Cúbits Algorítmicos (AQ), que mide las operaciones útiles antes de que los errores destruyan el resultado. Este enfoque en la calidad se valida con el giro estratégico de los líderes en volumen, quienes han reconocido que la reducción del ruido es el verdadero cuello de botella de la tecnología actual. Aunque los átomos-neutros se perfilan como el «caballo negro» al combinar escala y potencial calidad, el informe es enfático: el salto real dependerá de la Corrección de Errores Cuánticos (QEC). Este proceso, necesario para salir de la era ruidosa, convertirá múltiples–cúbits físicos defectuosos en estables cúbits lógicos tolerantes a fallos.

1. Fundamentos y Propósito: (Más allá de los Ceros y Unos)

-. Antes de diseccionar el hardware, debemos definir con precisión qué estamos manipulando. En la computación–clásica, operamos con bits–deterministas. En el caso que nos ocupa, operamos con Qubits.

-. El propósito de esta tecnología no es simplemente hacer «todo más rápido«. Su objetivo es resolver problemas que requieren una complejidad computacional exponencial, como la simulación de moléculas para farmacología, la optimización logística a gran escala y la criptografía avanzada (algoritmo de Shor).

Nota: Conceptos Físicos Claves para entender el hardware, debes entender dos fenómenos: (Superposición y Entrelazamiento (Entanglement)).

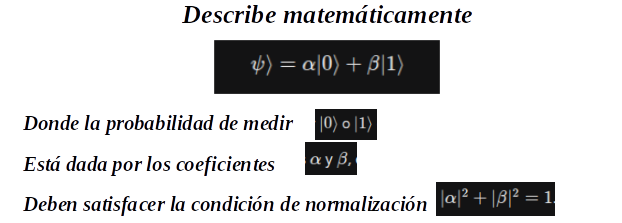

- Superposición: Un qubit no se limita a un estado binario definido. Antes de ser medido, existe simultáneamente como una combinación lineal de ambos estados |0⟩ o |1⟩ .1 El estado-cuántico se describe matemáticamente como:

Nota: Esta capacidad de existir en múltiples estados simultáneamente es la base del paralelismo masivo inherente a la computación cuántica.

- Entrelazamiento: El entrelazamiento es una correlación cuántica no clásica entre qubits. Si dos o más qubits están entrelazados, el estado de un qubit no puede describirse de forma independiente del estado de los demás. Este fenómeno de interdependencia es indispensable para la generación de la potencia computacional requerida para ejecutar algoritmos–cuánticos complejos.

2. El Estado Actual: (La Era NISQ)

-. La industria opera dentro del marco de la era–NISQ (Noisy Intermediate–Scale Quantum). Esta denominación define las limitaciones y oportunidades tecnológicas contemporáneas.

-. Los qubits son extremadamente frágiles. Son hipersensibles a las perturbaciones ambientales, como variaciones de temperatura y radiación electromagnética. Esta sensibilidad extrema conduce a la decoherencia, el proceso por el cual el qubit pierde rápidamente su preciado estado cuántico (superposición y entrelazamiento).

-. La ruidosidad impone una limitación directa sobre la profundidad de los circuitos cuánticos que pueden ejecutarse de manera confiable. Si un algoritmo requiere una larga secuencia de operaciones, la probabilidad acumulada de error se vuelve prohibitiva. Es esta ruidosidad la causa directa de que se hayan desarrollado métricas basadas en la calidad (como los Qubits Algorítmicos, AQ), ya que la fidelidad dicta la utilidad real del hardware, independientemente de la escala física.

2.1. Escala Intermedia: (Intermediate-Scale)

-. La industria ha logrado manejar un número significativo de qubits, con rangos que van desde 50 hasta más de 1,000. Sin embargo, esta escala es solo «intermedia«. A pesar del volumen, la cantidad es insuficiente para implementar los complejos y redundantes esquemas de corrección de errores cuánticos que son necesarios para alcanzar la computación tolerante a fallos, un requisito esencial para cualquier ordenador–cuántico–universal.

-. En el contexto de NISQ, la búsqueda de la «supremacía cuántica» o «ventaja cuántica» se limita a demostraciones en casos de uso muy específicos y altamente optimizados, ya que el hardware actual no es lo suficientemente robusto para abordar un espectro amplio de problemas comerciales.

3. Plataformas de Hardware: (Líderes)

-. A diferencia de la computación–clásica, donde el silicio es el estándar, la computación–cuántica presenta múltiples modalidades físicas en competencia. Cada plataforma busca optimizar la escalabilidad y la fidelidad (menor tasa de error), forzando a los ingenieros a gestionar compromisos inherentes.

3.1. Qubits Superconductores: (El Enfoque de Estado Sólido)

-. Esta es la arquitectura más visible y madura en la actualidad, adoptada por líderes industriales como IBM y Google.

- Funcionamiento: Se basan en Uniones Josephson, que son circuitos electrónicos fabricados con materiales superconductores (como niobio o aluminio). Estos circuitos se comportan como «átomos artificiales«.

- Infraestructura: Requieren una infraestructura de enfriamiento compleja y masiva. Los procesadores deben mantenerse a temperaturas cercanas al cero absoluto (miliohelvin) dentro de refrigeradores de dilución masivos.

- Ventajas: Ofrecen velocidades de compuerta (gate speeds) muy rápidas y se benefician de utilizar técnicas de litografía similares a las empleadas en la fabricación de chips clásicos, lo que facilita la escalabilidad de la producción física.

- Desafíos: Sus principales debilidades son los tiempos de coherencia cortos, lo que significa que la información–cuántica se pierde rápidamente. Además, requieren una calibración intensiva y constante para mantener el rendimiento.

- Líderes: IBM, Google, Rigetti.

3.2. Iones Atrapados: (Trapped Ions)

. Si los superconductores crean átomos artificiales, este enfoque trabaja directamente con átomos reales cargados (iones).

- Funcionamiento: Utilizan iones (comúnmente de Iterbio o Calcio) que son «atrapados» en el vacío mediante campos electromagnéticos. La manipulación del estado–cuántico y la ejecución de compuertas lógicas se realizan mediante láseres de precisión.

- Ventajas Estratégicas: Su principal fortaleza es el tiempo de retención de la información–cuántica. Poseen tiempos de coherencia excepcionales, significativamente más largos que los superconductores. Adicionalmente, esta arquitectura permite una conectividad «todos con todos» (fully-connected), lo que significa que cualquier qubit puede interactuar directamente con cualquier otro, simplificando drásticamente el mapeo y la arquitectura de los algoritmos.

- Desafíos: Las compuertas son inherentemente más lentas que las implementadas en sistemas superconductores. Además, existe una dificultad física significativa para escalar el número de iones en una sola trampa sin comprometer la fidelidad y el control individual.

- Líderes: IonQ, Quantinuum (resultado de la fusión entre Honeywell Quantum Solutions y CQC).

3.3. Plataformas Emergentes: (Fotónica y Átomos Neutros)

-. El panorama de hardware se complementa con enfoques que buscan romper los límites de las plataformas líderes.

3.3.1. Fotónica: (Photonics)

-. Este método codifica la información–cuántica en los estados de los fotones (luz), utilizando su polarización o tiempo de llegada, y los guía a través de guías de onda de fibra óptica avanzada.

- Ventajas: Presenta el potencial de funcionar a temperatura ambiente para muchos de sus componentes, y es altamente integrable con la infraestructura de telecomunicaciones existente.

- Desafíos Críticos: La dificultad principal reside en que los fotones no interactúan naturalmente entre sí, lo que complica enormemente la creación de compuertas-lógicas de dos qubits. La pérdida de fotones (loss) es otro problema crítico de ingeniería.

- Líderes: PsiQuantum, Xanadu.

3.3.2. Átomos Neutros: (Neutral Atoms)

-. Esta arquitectura utiliza átomos sin carga que se manipulan con trampas ópticas. Ha demostrado ser una tecnología de escalabilidad rápida.

- Hitos Recientes: Atom Computing ha anunciado la superación de la barrera de los 1,000 qubits físicos, y estos sistemas destacan por ofrecer tiempos de coherencia muy largos.

- Implicación Estratégica: Si los Átomos Neutros logran combinar alta escalabilidad (>1000 qubits) con la alta fidelidad y coherencia prolongada, esto podría representar la ruptura del modelo de «Trade-off Triangle» (Escala vs. Calidad) que domina la era NISQ. Se posicionan como un competidor serio a mediano plazo, capaz de desafiar tanto a los superconductores en volumen como a los iones atrapados en calidad de coherencia.

4. Métricas Reales: (Qubits Estables y Disponibilidad Comercial)

-. Aquí es donde debemos ser críticos. El «número de qubits físicos» es una métrica de vanidad si la tasa de error es alta. La industria se está moviendo hacia métricas como el Volumen Cuántico o Qubits Algorítmicos (AQ).

-. A continuación, el despliegue comercial actual (accesible generalmente vía nube como AWS Braket, Azure Quantum o IBM Cloud):

4.1. El Ecosistema Superconductor:

4.1.1. IBM: (Es el líder en volumen de despliegue)

- Procesador Eagle: 127 qubits (muy estable y accesible).

- Procesador Osprey: 433 qubits.

- Procesador Condor: 1,121 qubits físicos. (Hito técnico alcanzado recientemente).

- Nota del Ingeniero: IBM está pivotando ahora hacia el procesador Heron (133 qubits), priorizando la calidad de las conexiones y la reducción de ruido sobre el conteo bruto de qubits.

4.1.2. Google: (Google Quantum AI)

- Su procesador Sycamore tiene 53-70 qubits, pero están altamente optimizados para demostrar la ventaja cuántica en tareas específicas. No son tan públicamente accesibles como IBM.

4.2. El Ecosistema de Iones Atrapados:

Nota: Aquí los números son menores, pero la calidad por qubit es inmensamente superior.

4.2.1. IonQ:

- Ofrece sistemas como el IonQ Forte.

- Se miden en «Qubits Algorítmicos» (AQ). Actualmente alcanzan AQ 35–36. Esto significa que pueden ejecutar circuitos profundos y complejos con esa cantidad de variables, algo que sistemas superconductores con más qubits–físicos a veces no logran debido al ruido.

4.2.2. Quantinuum:

- Sistemas H-Series (H1, H2).

- El modelo–H2 ha demostrado 32 qubits totalmente conectados con la fidelidad más alta de la industria (99.9% en operaciones de dos qubits). Recientemente demostraron hitos importantes en la creación de qubits lógicos (con corrección de errores).

4.2.3. El Ecosistema de Átomos Neutros: (Emergente)

Nota: Vale la pena mencionar a Atom Computing y Pasqal.

- Atom Computing anunció recientemente haber superado la barrera de los 1,000 qubits usando átomos neutros, con tiempos de coherencia muy largos, posicionándose como un competidor serio para los superconductores en escalabilidad.

Una representación visual de información: (Infografía)

Resumiendo: mi diagnóstico del estado actual es el siguiente:

Madurez: Estamos saliendo de la infancia de la física experimental para entrar en la adolescencia de la ingeniería de sistemas. Ya no nos preguntamos si funciona, sino cómo escalarlo.

Liderazgo de Hardware:

- IBM (Superconductores) gana la carrera de la escala física (>1000 qubits).

- Quantinuum/IonQ (Iones) ganan la carrera de la calidad y fidelidad (menos errores por operación).

Realidad Comercial: La tecnología es accesible hoy vía nube para investigación y pruebas de concepto (PoC). Sin embargo, para aplicaciones comerciales productivas que superen económicamente a las clásicas, necesitamos mejores esquemas de corrección de errores, no solo más qubits.

Recopilando:

-. Veamos los puntos mas importantes de este post:

- La computación cuántica actual se describe como una batalla entre el enfoque en la Cantidad y el enfoque en la Calidad.

- El enfoque en la Cantidad utiliza la tecnología de Cúbits Superconductores.

- Los líderes en escala de cúbits superconductores son IBM y Google.

- Estos líderes han superado los 1,000 cúbits físicos, priorizando el volumen.

- Una de las ventajas de los cúbits superconductores es la velocidad de sus operaciones.

- Además, utilizan técnicas de fabricación escalables.

- El desafío de los cúbits superconductores es el ruido y la corta coherencia.

- Debido a estos desafíos, la información cuántica se pierde rápidamente.

- La pérdida rápida de información limita la capacidad de realizar cálculos complejos.

- El enfoque en la Calidad se centra en el uso de Iones Atrapados.

- Las empresas líderes en fidelidad que emplean Iones Atrapados son IonQ y Quantinuum.

- Una de las ventajas clave de los iones atrapados es su estabilidad y conectividad.

- Ofrecen tiempos de coherencia excepcionales.

- Permiten una conexión total entre todos los cúbits.

- Los sistemas de iones atrapados se miden utilizando Cúbits Algorítmicos (AQ).

- El Cúbit Algorítmico (AQ) es una métrica de utilidad real.

- El desafío principal de los iones atrapados es la lentitud y el escalado.

- Las operaciones que emplean iones atrapados son más lentas en comparación.

- Aumentar el número de iones para el escalado es difícil.

- El futuro de la computación cuántica contempla la emergencia de Átomos Neutros (que combinan gran escala, >1,000 cúbits, con largos tiempos de coherencia) y el Santo Grial de la Corrección de Errores Cuánticos (QEC), que utilizará muchos cúbits físicos para crear un único cúbit lógico estable y sin fallos.

- Referencias: moreluz.entorno

- Referencias: Cisco

- Referencias: NotebookLM