Prologo: La Computación Cuántica (CC) se presenta como el avance tecnológico más disruptivo desde la invención del transistor, utilizando principios de la mecánica cuántica para abordar problemas de complejidad intratable para los sistemas clásicos. Su arquitectura se basa en el qubit, la unidad fundamental que aprovecha la superposición y el entrelazamiento para codificar y procesar información de manera exponencialmente más potente. Sin embargo, la industria está inmersa en la Era NISQ, enfrentando el desafío fundamental de la decoherencia, que es la pérdida del estado cuántico debido a la interacción ambiental y el ruido. El rendimiento utilizable de estos sistemas se evalúa mediante el Quantum Volume (QV), una métrica que demuestra que la calidad, fidelidad y conectividad total de los qubits son más críticas que su número bruto para lograr utilidad práctica. El objetivo definitorio a largo plazo es alcanzar la tolerancia a fallos, lo cual depende de la implementación eficiente de la Corrección de Errores Cuánticos (QEC) para crear un qubit lógico confiable. Actualmente, la utilidad se manifiesta a través de modelos híbridos (QaaS) y en la simulación avanzada de materiales, la optimización y el desarrollo de la Inteligencia Artificial Cuántica.

Indice-Contenido:

- Computación Cuántica: (Propósito Estratégico, Fundamentos y Desafíos Estructurales (Era NISQ))

- Principales Actores Globales; (sus Enfoques Tecnológicos)

- La Carrera Hacia la Tolerancia a Fallos y (la Ingeniería de Software Cuántico)

- Impulsores Clave: (Centros Académicos y Ecosistemas Gubernamentales)

- Implicaciones Estratégicas y Aplicaciones: (Del Corto al Largo Plazo)

- Resumen Ejecutivo: (Conclusiones Finales)

Resumen de Audio:

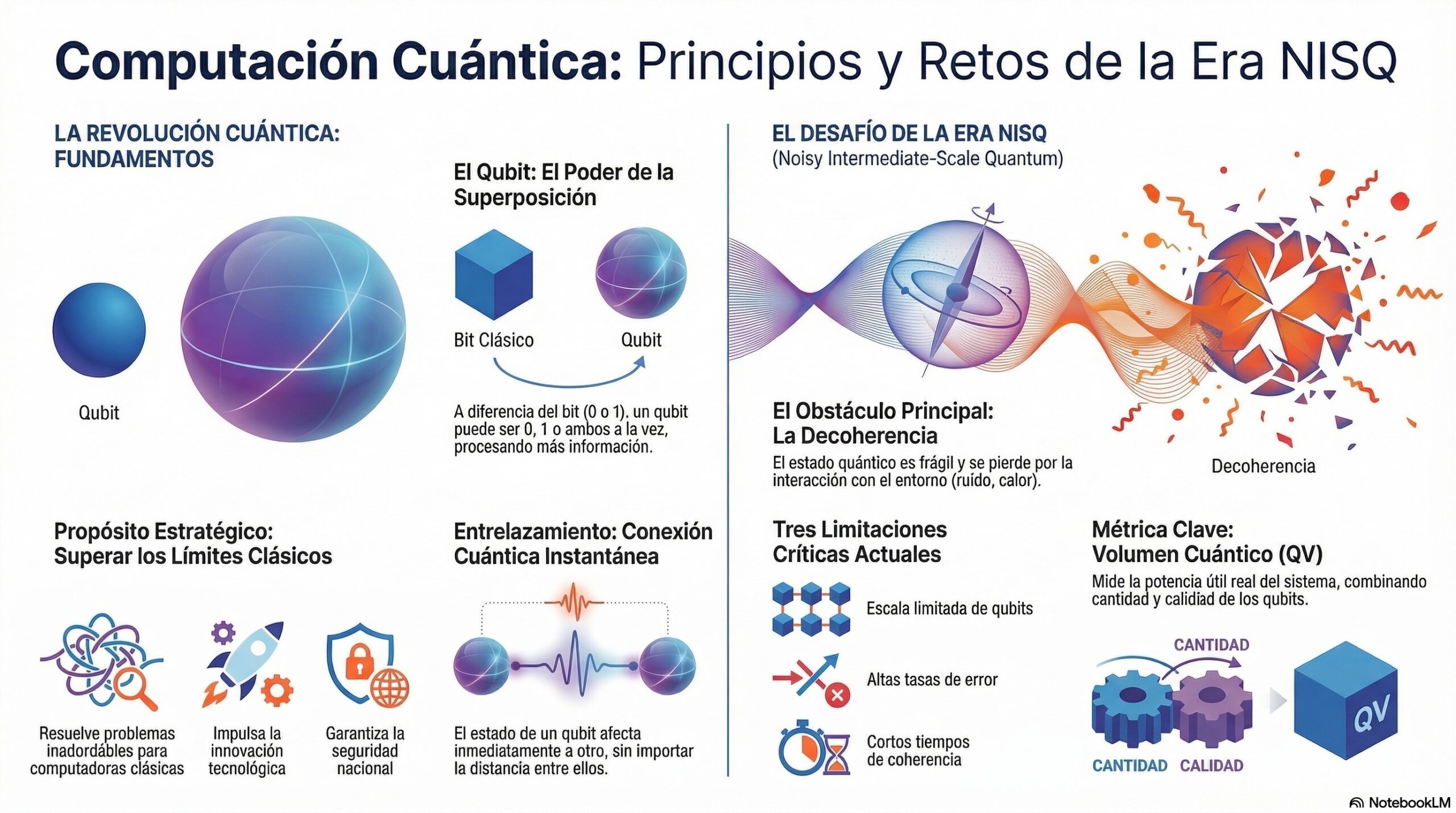

Principio y Retos: (de la Era-NISQ)

-. El post da una visión general de los principales actores globales y sus enfoques tecnológicos en el campo de la computación cuántica (CC). Se identifica un ecosistema diverso que incluye grandes corporaciones tecnológicas (Big Tech), las cuales dominan el acceso al mercado mediante modelos de Quantum-as-a-Service (QaaS), y startups especializadas. Las grandes empresas como IBM y Google se centran en qubits superconductores, mientras que Microsoft persigue la arquitectura más arriesgada de qubits topológicos de Majorana (partículas exóticas) para lograr una resistencia intrínseca a la decoherencia. Por otro lado, Intel apuesta por qubits de espín en silicio para aprovechar las técnicas de fabricación existentes. Las startups, como se detalla en la tabla, exploran arquitecturas alternativas como Iones Atrapados y Átomos Neutros, enfocándose en mejorar la fidelidad y la escalabilidad. Finalmente, el documento subraya que la meta estratégica ha evolucionado: la prioridad ya no es el número de qubits físicos, sino alcanzar una Corrección de Errores Cuánticos (QEC) eficiente para crear un qubit lógico utilizable.

1. Computación Cuántica: (Propósito Estratégico, Fundamentos y Desafíos Estructurales (Era NISQ))

-. La Computación Cuántica (CC) representa el avance tecnológico más disruptivo en el procesamiento de información desde la invención del transistor, al utilizar los principios fundamentales de la mecánica cuántica para abordar problemas de complejidad intratable para los sistemas clásicos.

1.1. Propósito Estratégico Global:

-. El motor de esta aceleración tecnológica está arraigado en la necesidad estratégica de superar los límites físicos impuestos por la Ley de Moore. La CC es la única alternativa viable para desbloquear la próxima era de innovación industrial y el procesamiento de datos masivos , centrándose en alcanzar la Ventaja Cuántica el punto en el que un ordenador cuántico resuelve un problema útil de manera demostrablemente más rápida que el mejor superordenador clásico. Además, el desarrollo de la CC está intrínsecamente ligado al imperativo de la seguridad nacional , lo que ha provocado una inversión gubernamental masiva (USD 3.1 mil millones en 2024) en esta carrera global por la supremacía cuántica.

1.2. Fundamentos Cuánticos Esenciales:

Nota: La arquitectura de la CC se basa en principios físico-cuánticos

- El Qubit y la Superposición: La unidad fundamental es el qubit (bit cuántico). A diferencia del bit clásico (0 o 1), el qubit puede existir en un estado de superposición de 0, 1 o una combinación de ambos simultáneamente. Esta propiedad permite que un sistema de N qubits codifique y procese 2N estados de información en paralelo, lo que constituye la fuente de su poder computacional.

- Entrelazamiento e Interferencia Cuántica: El Entrelazamiento describe una correlación profunda entre qubits vinculados de tal manera que el estado de uno afecta inmediatamente a los demás, independientemente de la distancia que los separe. Los algoritmos cuánticos aprovechan ambos fenómenos para manipular los estados mediante Interferencia Cuántica. Esta interferencia se utiliza para amplificar las probabilidades de los resultados correctos (soluciones) y anular las probabilidades de los resultados incorrectos.

1.3. El Desafío Fundamental: (La Decoherencia)

-. El principal obstáculo de ingeniería es la Decoherencia , que es la pérdida del estado cuántico (superposición y entrelazamiento) al colapsar a un estado clásico. La decoherencia es causada por la interacción con el ambiente, incluyendo el ruido térmico, fluctuaciones de voltaje o interferencia electromagnética. La sensibilidad extrema a estos factores limita la duración útil de cualquier cálculo cuántico al tiempo de coherencia. Por lo tanto, el desarrollo de hardware cuántico está dominado por la necesidad de aislar físicamente los qubits y minimizar el ruido, una incapacidad que restringe el potencial teórico exponencial de la cuántica a la Era NISQ.

1.4. El Estado de la Cuestión: (La Era NISQ y sus Limitaciones)

-. La industria se encuentra en la Era NISQ (Noisy Intermediate-Scale Quantum), caracterizada por dispositivos funcionales con limitaciones críticas en escala, fidelidad y tiempo de coherencia. Los sistemas NISQ se enfrentan a tres limitaciones principales que impiden la ejecución de algoritmos tolerantes a fallos:

- Escala Abarcable: Aunque el hito de los 1,000 qubits fue superado por Atom Computing (1,180 qubits en octubre de 2023), el número de qubits es generalmente acotado.

- Altas Tasas de Error: Los sistemas sufren de elevadas tasas de error debido al ruido constante , que puede ser sistemático o estocástico, reduciendo drásticamente la fidelidad de las operaciones.

- Coherencia Reducida: Los tiempos de coherencia limitan la profundidad de los circuitos que pueden ejecutarse de manera confiable.

-. La gestión eficiente de recursos y la mitigación de errores mediante técnicas de post-procesamiento de datos son esenciales para extraer resultados significativos de estos dispositivos ruidosos, dado que carecen de corrección de errores cuánticos a escala completa.

1.5. Conectividad y Métrica de Rendimiento: (Quantum Volume)

Nota: La conectividad entre qubits es clave para la eficiencia y la tasa de error.

- En arquitecturas de qubits superconductores (IBM, Google), la conectividad limitada requiere operaciones adicionales (Swap gates) para entrelazar qubits no adyacentes, lo que añade complejidad y eleva la tasa de error global.

- En contraste, los sistemas de Iones Atrapados (IonQ, Quantinuum) suelen ofrecer conectividad total, permitiendo compuertas entrelazantes directas, lo que contribuye a una mayor fidelidad y rendimiento superior en la Era NISQ.

-. Para medir la capacidad utilizable del sistema, IBM desarrolló el Quantum Volume (QV).13 El QV es una métrica compuesta que integra la cantidad de qubits con su calidad (fidelidad de las compuertas, tiempo de coherencia y conectividad), midiendo la potencia utilizable del ordenador bajo carga. Quantinuum ha marcado un hito significativo en esta área, alcanzando un QV 2-23 (8,388,608) en su sistema H2, un rendimiento que demostró la capacidad del sistema H2-1 para mantener la coherencia en un problema de optimización combinatoria de 56 qubits con resultados útiles que exceden las capacidades de simulación exacta de los superordenadores clásicos.

Una representación visual de información: (Infografía)

Nota: Esta infografía detalla los fundamentos y obstáculos de la computación cuántica durante la actual era NISQ. Explica que el uso de qubits permite procesar información mediante la superposición y el entrelazamiento, superando así las capacidades de la informática tradicional. Sin embargo, el sector enfrenta el gran reto de la decoherencia, donde factores externos como el ruido o el calor interrumpen los procesos. Para medir el rendimiento real frente a estas limitaciones, se utiliza el volumen cuántico, una métrica que equilibra la cantidad y calidad de los componentes. En última instancia, el objetivo es resolver problemas complejos que impulsen la innovación tecnológica y refuercen la seguridad nacional.

2. Principales Actores Globales: (sus Enfoques Tecnológicos)

-. El desarrollo de la CC está impulsado por un ecosistema diverso de corporaciones, startups especializadas y centros de investigación, cada uno apostando por arquitecturas de qubits distintas para resolver el compromiso entre escalabilidad y fidelidad.

2.2. Grandes Corporaciones Tecnológicas: (Big Tech)

-. Estas corporaciones no solo construyen hardware, sino que también dominan el acceso al mercado a través de modelos de Quantum-as-a-Service (QaaS), que permiten a los usuarios acceder a la inmensa potencia de cálculo cuántica a través de la nube sin requerir la posesión de hardware físico.

- IBM y Google (Superconductores): IBM, con sede en EE. UU., se enfoca en el escalado rápido de sus qubits superconductores, logrando duplicar la velocidad de desarrollo de nuevos procesadores y aumentar la complejidad física de sus chips. Google, también centrado en superconductores, ha invertido en herramientas de software cuántico como Qualtran para la estimación de recursos.

- Microsoft (Topológicos): La estrategia de Microsoft, centralizada en su plataforma Azure Quantum, es la más arriesgada y visionaria, apuntando al desarrollo de qubits topológicos de Majorana. Esta arquitectura promete una resistencia intrínseca a la decoherencia, lo que reduciría el overhead de la Corrección de Errores Cuánticos (QEC) necesario para construir un ordenador tolerante a fallos de un millón de qubits.

- Intel (Espín en Silicio): Intel se concentra en la tecnología de qubits de espín en silicio. Esta apuesta busca aprovechar la madurez de las técnicas de fabricación de semiconductores existentes para lograr una ventaja de escalabilidad y producción a largo plazo.

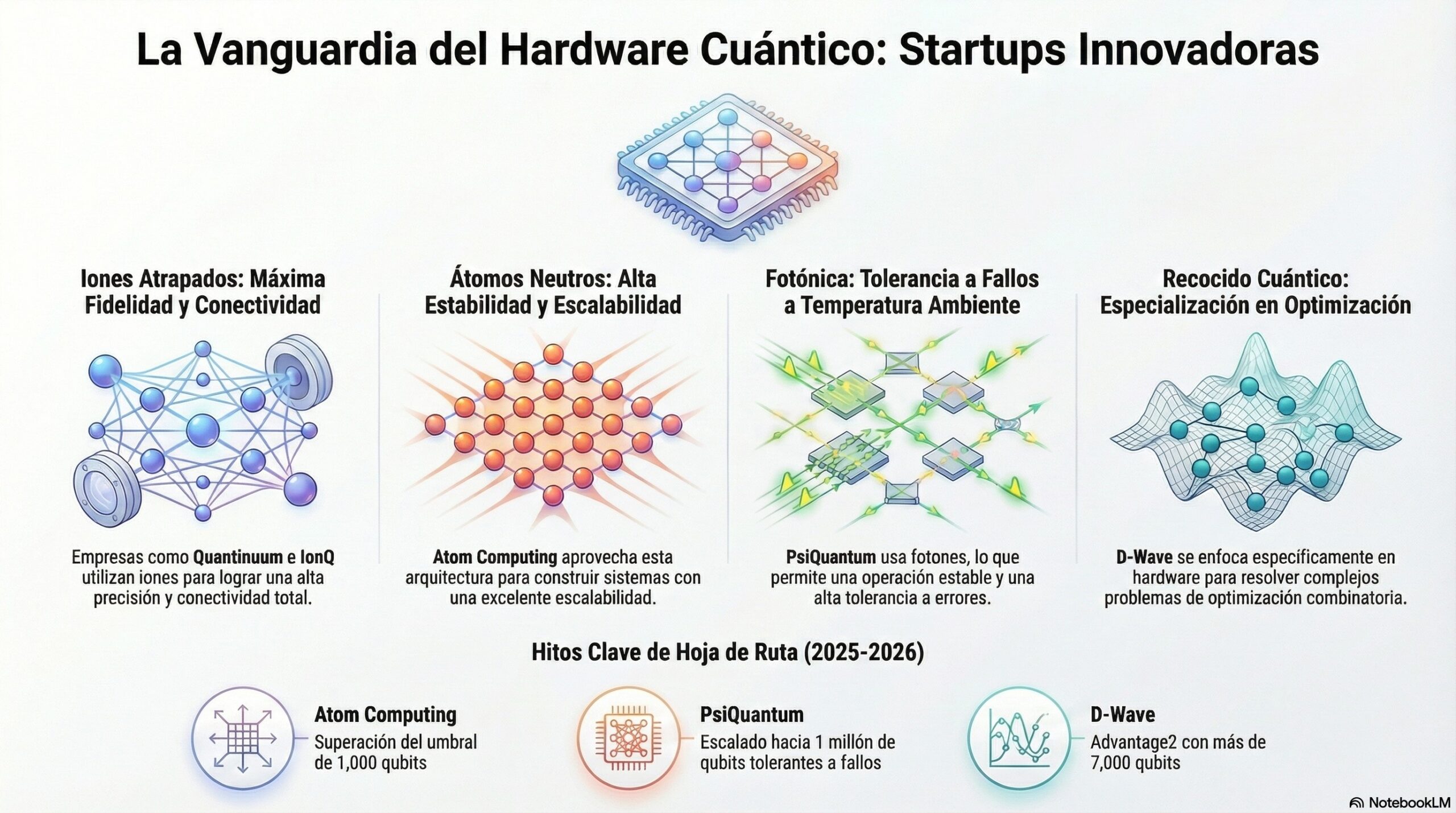

2.3. Startups y Especialistas en Hardware:

-. Las startups están impulsando arquitecturas alternativas que buscan resolver los problemas de fidelidad y escalabilidad de manera innovadora.

Nota: La imagen presenta una Infografía que describe el papel de las startups y especialistas en hardware en el desarrollo de arquitecturas cuánticas alternativas. Esta Infografía se enfoca en cómo estas empresas buscan resolver los desafíos de fidelidad y escalabilidad de manera innovadora. La información se organiza por empresa, listando su arquitectura primaria (como Iones Atrapados o Cúbits de Gat) y la ventaja tecnológica clave que ofrece cada una. Además, se indican los hitos de la hoja de ruta que las compañías esperan alcanzar en los próximos años, incluyendo métricas como el Volumen Cuántico o el número de cúbits. La Infografía es un resumen de la competencia en hardware cuántico y sus objetivos a corto y mediano plazo.

-. Un factor decisivo en la evolución de las arquitecturas de Iones Atrapados es la implementación de la fotónica integrada. Este enfoque resuelve el desafío de escalar las trampas de iones, que están limitadas por la repulsión electrostática, al utilizar fotones para enredar iones en diferentes trampas, eliminando la necesidad de mover físicamente los átomos y facilitando el escalado.

-. El hecho de que empresas como Microsoft y Alice & Bob estén desarrollando qubits con corrección de errores intrínseca es una señal de la evolución del enfoque estratégico. La carrera ya no se trata solo de construir el chip con el mayor número de qubits físicos, sino de lograr la Corrección de Errores más eficiente y económica, minimizando la sobrecarga de recursos para obtener un qubit lógico utilizable.

3. La Carrera Hacia la Tolerancia a Fallos: (la Ingeniería de Software Cuántico)

-. La transición a la era Beyond-NISQ, donde los ordenadores cuánticos podrán ejecutar algoritmos complejos como el de Shor, depende de avances fundamentales en la gestión de errores y el desarrollo de herramientas de software robustas.

3.1. Avances en la Corrección de Errores Cuánticos: (QEC)

-. La QEC (Corrección de Errores Cuánticos) es el desafío tecnológico definitorio de la industria. El objetivo es proteger la información cuántica del ruido mediante la redundancia. El Surface Code es el código más prometedor debido a su relativa robustez y bajo overhead, aunque el costo de qubits sigue siendo alto. Se esperan avances en 2025 y más allá con la exploración de códigos más eficientes, como los QLDPC (Quantum Low-Density Parity-Check), que buscan reducir la cantidad de qubits físicos requeridos por qubit lógico.

-. Avances recientes indican un potencial para acortar el calendario: las investigaciones de Microsoft sugieren que una reducción significativa en las tasas de error podría requerir solo un pequeño número de qubits (potencialmente cuatro) para formar un qubit lógico confiable. Esta mejora en la eficiencia de la QEC es fundamental para desbloquear la escalabilidad prometida.

3.2. Ingeniería de Software Cuántico y QaaS:

Nota: El software juega un papel crucial en la optimización de los cálculos en el hardware ruidoso de la Era NISQ.

- Quantum-as-a-Service (QaaS): El modelo QaaS, liderado por actores como IBM y AWS , permite a empresas e investigadores ejecutar algoritmos a través de la nube, pagando solo por el tiempo de cálculo utilizado. Esto ha sido vital para acelerar la innovación al superar los altos costes y la complejidad de mantenimiento del hardware cuántico.

- Estimación y Gestión de Recursos: La complejidad de la corrección de errores requiere herramientas para la Estimación de Recursos Cuánticos (QRE). Proyectos como Azure Quantum QRE y Qualtran (Google) permiten a los ingenieros predecir los recursos necesarios antes de la ejecución. Este desarrollo de software de ingeniería representa una madurez estratégica en la industria, enfocándose en la viabilidad económica y el costo de la tolerancia a fallos.

- Algoritmos Híbridos: La investigación actual se centra en Algoritmos Cuánticos Variacionales (VQA) que combinan procesadores cuánticos para tareas específicas y ordenadores clásicos para la optimización. Esta sinergia es clave, y el posicionamiento de la CC como un complemento a la Inteligencia Artificial (IA) ha demostrado atraer niveles de inversión un 33% más altos

4. Impulsores Clave: (Centros Académicos y Ecosistemas Gubernamentales)

Nota: El avance de la CC es un esfuerzo global coordinado que depende de infraestructuras académicas y de la estandarización gubernamental.

4.1. Ecosistemas de Investigación y Acceso:

-. El compromiso financiero tanto del sector privado (con grandes inversiones estratégicas como los USD 10 mil millones anunciados por JPMorgan Chase) como del sector público es fundamental.

- Forschungszentrum Jülich (JUNIQ): Este centro alemán opera la Jülich User Infrastructure for Quantum Computing (JUNIQ), proporcionando acceso a sistemas cuánticos (incluyendo D-Wave) a investigadores europeos.

- Integración HPC Europea (EuroQCS): La estrategia europea, a través del programa Europa Digital, financia EuroQCS para integrar ordenadores y simuladores cuánticos en red con la infraestructura de Supercomputación de Alto Rendimiento (EuroHPC). Este enfoque confirma que la utilidad inicial se logrará mediante sistemas cuánticos operando como aceleradores de HPC clásica.

4.2. El Papel del NIST: (en la Estandarización de Seguridad)

-. La amenaza del Algoritmo de Shor, que puede factorizar números enteros y romper la criptografía asimétrica actual (RSA) en minutos , ha obligado a una respuesta estratégica global.

-. El Instituto Nacional de Estándares y Tecnología (NIST) de EE. UU. ha liderado el esfuerzo de estandarización de algoritmos de Criptografía Post-Cuántica (PQC). Estos nuevos estándares (como CRYSTALS-Kyber y CRYSTALS-Dilithium) son cruciales para proteger los canales de comunicación y la infraestructura digital contra futuros ataques cuánticos. La finalización y adopción de estos estándares PQC indican que la amenaza cuántica ha transformado la ciberseguridad global, requiriendo una migración planificada y coordinada en todas las cadenas de suministro.

5. Implicaciones Estratégicas y Aplicaciones: (Del Corto al Largo Plazo)

Nota:La utilidad de la CC se proyecta en áreas donde el espacio de soluciones crece exponencialmente con el tamaño del problema.

5.1. Simulación y Ciencia de Materiales:

-. La simulación de sistemas cuánticos es la aplicación fundacional de la CC. Los ordenadores cuánticos poseen una ventaja significativa sobre los clásicos para modelar interacciones moleculares complejas.

- Química Cuántica: Esencial para el diseño de nuevos fármacos y el desarrollo de materiales avanzados. Los problemas relacionados con la ciencia de materiales y los electrones fuertemente interactuantes se consideran los más cercanos a lograr la ventaja cuántica industrial.

- Energía: La simulación cuántica puede acelerar la investigación en fuentes de energía sostenible y renovable, como el diseño de mejores baterías y combustibles.

5.2. Optimización y Logística:

Nota: La CC es una herramienta poderosa para resolver problemas de optimización combinatoria.

- Logística y Transporte: Algoritmos cuánticos pueden optimizar rutas de envío y distribución a nivel global, permitiendo la asignación de recursos y la gestión de tráfico en tiempo real, superando los límites de los supercomputadores actuales.

5.3. Inteligencia Artificial Cuántica: (QAI)

Nota: La QAI aprovecha la superposición y el entrelazamiento para mejorar el aprendizaje automático.

- Impacto en IA: La CC puede reducir el tiempo de entrenamiento de modelos de IA, optimizar hiperparámetros y utilizar métodos avanzados de clasificación como el Quantum Support Vector Machine (QSVM). La sinergia entre la cuántica y la IA es reconocida como un motor potencial para la próxima generación de tecnologías Watson y sistemas de aprendizaje profundo.

Discreción: Esta infografía detalla el panorama actual y las perspectivas venideras de la computación cuántica, subrayando que la corrección de errores es el obstáculo técnico más crítico a superar. El contenido explica que el acceso remoto mediante la nube está permitiendo que diversas industrias experimenten con este hardware avanzado sin necesidad de poseerlo físicamente. No obstante, se advierte sobre una amenaza a la ciberseguridad, ya que la potencia de estos sistemas podría vulnerar los métodos de cifrado tradicionales. Por otro lado, el impacto positivo se reflejará en la simulación científica, permitiendo el descubrimiento de fármacos y nuevos materiales con una precisión sin precedentes. Finalmente, la integración con la inteligencia artificial y la optimización logística prometen resolver desafíos complejos que las supercomputadoras convencionales no pueden procesar eficientemente.

6. Resumen Ejecutivo: (Conclusiones Finales y Perspectivas Estratégicas)

. El estado actual de la Computación Cuántica está marcado por el éxito en la demostración de sistemas funcionales (Era NISQ) y una competencia tecnológica centrada en la eficiencia de la corrección de errores para alcanzar la tolerancia a fallos.

- Prioridad de la Fidelidad sobre la Escala Bruta: La demostración de un Quantum Volume alto por sistemas de Iones Atrapados (Quantinuum) establece que la calidad, fidelidad y conectividad total de los qubits son más críticas para la utilidad práctica hoy que el simple recuento de qubits físicos.

- Desafío de la Tolerancia a Fallos: La transición a la era Beyond–NISQ, proyectada para 2030-2040, depende de la implementación eficiente de la Corrección de Errores Cuánticos (QEC). La ventaja estratégica a largo plazo será para los actores que desarrollen arquitecturas (qubits topológicos, Cat Qubits) capaces de reducir significativamente el overhead de qubits-físicos necesarios para crear un qubit-lógico utilizable.

- Hibridación como Paradigma Actual: El acceso mediante QaaS y la integración de sistemas cuánticos en la infraestructura HPC (EuroQCS) indican que la utilidad inmediata de la CC se manifestará a través de modelos híbridos, donde los procesadores cuánticos actúan como aceleradores especializados para tareas de simulación y optimización, asistidos por la vasta capacidad de gestión de datos de la computación clásica.

- Riesgo Inminente en Criptografía: El riesgo cuántico más urgente es la obsolescencia de los estándares criptográficos asimétricos. La madurez de los algoritmos de Criptografía Post-Cuántica (PQC) seleccionados por el NIST obliga a las organizaciones a iniciar ya la migración de la infraestructura de seguridad para mitigar la amenaza del «harvest now, decrypt later«.

Recopilando:

-. Veamos los puntos mas importantes de este post:

- La computación cuántica se considera el avance tecnológico más disruptivo desde el transistor, utilizando la mecánica cuántica para resolver problemas complejos inalcanzables para la informática clásica.

- Su unidad fundamental es el qubit, que permite procesar información masiva mediante los principios de superposición y entrelazamiento.

- El principal desafío de ingeniería es la decoherencia, que es la pérdida del estado cuántico debido a la interacción con el ruido ambiental o el calor.

- La industria atraviesa actualmente la Era NISQ, caracterizada por dispositivos con limitaciones en escala, fidelidad y tiempos de coherencia reducidos.

- El Quantum Volume (QV) es la métrica que demuestra que la calidad, fidelidad y conectividad de los qubits son más importantes que su número bruto.

- Grandes corporaciones como IBM y Google se centran en qubits superconductores, dominando el mercado mediante el modelo de Quantum-as-a-Service (QaaS).

- Microsoft persigue una estrategia arriesgada con qubits topológicos, buscando una resistencia intrínseca a la decoherencia para facilitar la corrección de errores.

- Startups innovadoras exploran arquitecturas alternativas como los iones atrapados, átomos neutros y fotónica para mejorar la escalabilidad.

- El objetivo estratégico fundamental es alcanzar la tolerancia a fallos mediante la implementación eficiente de la Corrección de Errores Cuánticos (QEC).

- La utilidad actual se manifiesta en modelos híbridos, donde los sistemas cuánticos actúan como aceleradores especializados para la infraestructura de supercomputación clásica.

- En el corto y largo plazo, la computación cuántica promete revolucionar la ciencia de materiales y la química para el desarrollo de fármacos y baterías.

- La Inteligencia Artificial Cuántica (QAI) aprovecha el entrelazamiento para optimizar el aprendizaje automático y reducir los tiempos de entrenamiento de modelos de IA.

- Existe una amenaza crítica para la seguridad global, ya que la potencia cuántica podría vulnerar los métodos de cifrado tradicionales (RSA).

- El NIST está liderando la estandarización de la Criptografía Post-Cuántica (PQC) para proteger las comunicaciones digitales contra futuros ataques cuánticos.

- La transición hacia una era más allá de NISQ, con algoritmos complejos y qubits lógicos confiables, se proyecta para el periodo 2030-2040.

- Referencias: moreluz.entorno

- Referencias: Cisco

- Referencias: NotebookLM