Prologo: En este post tenemos la presentación de Gemini-1.5 del lenguaje de Google, lo situamos cronológicamente en el 2024 es sin duda la competencia directa de GPT-4 de OpenAI .

¡Que es! Gemini

-. Gemini-1.5 próxima generación del modelo de lenguaje de Google es una inteligencia artificial iA generativa, basado en el es un Large-Language-Model LLM, modelo multimodal de uso general en el sistema de Google puede entender Testo, Sonidos, imagenes y videos. Usa la Arquitectura-red-neuronal de los Transformers.

Aclaremos algunos conceptos:

- .Que es LLM: Un Large-Language-Model o LLM, conocido también como modelo de lenguaje de gran tamaño, este modelo de lenguaje se compone de una Network-Neuronal con muchos muchos parámetros y un entrenamientos de grades cantidades de datos. Estos datos están sin etiquetar, entrenamiento mediante Aprendizaje-Autosupervisado.

- .Que es el Aprendizaje auto-supervisado: Self-supervised learning, Nos encontramos con una técnica donde los datos de de entrenamiento se auto-etiquetan de forma autónoma una parte de la entrada de la Network-Neuronal, se usa como supervisión para predecir la parte restante del Input de la Network-Neuronal.

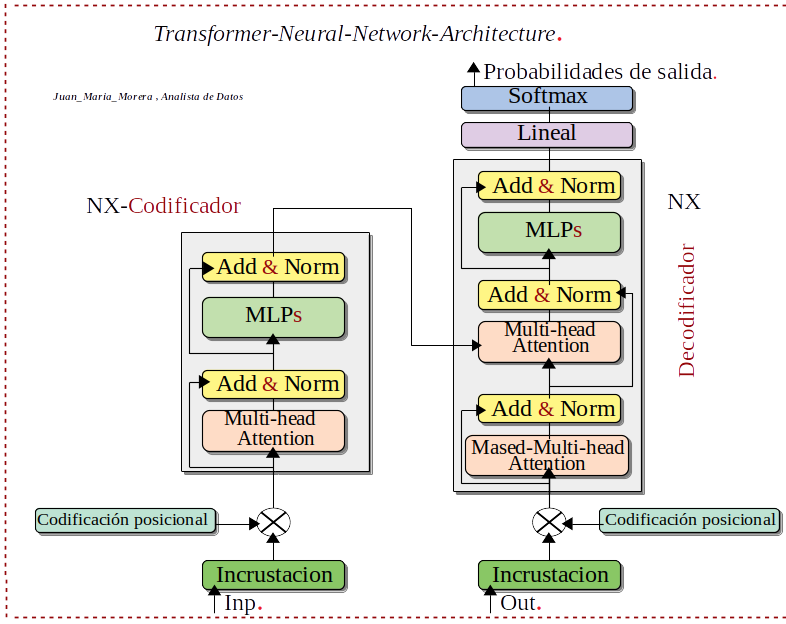

- .Que son los Transformers: Arquitectura-red-neuronal, Los transformers son un tipo de arquitectura de Network-Neuronal que transforma o cambia una secuencia de entrada en una secuencia de salida. ¡Como hace esto! Aprendiendo del contexto y rastrean las relaciones entre los componentes de la secuencia. Los Transformers están reemplazando en determinadas ocasiones a las Network-Neuronal convolucionales y recurrentes.

-. Podemos destacar dos conceptos importantes en este Modelo-Google-iA Gemini-1.5 en primer lugar tenemos la técnica MoEs que básicamente convierte la Inteligencia-Artificial-iA en subredes especializadas, llamadas Experts se activa según la consulta que hagamos. Mejora notablemente en el rendimiento a nivel de inferencia.

-. En segundo lugar tenemos las Ventanas-Contexto-iA no es otra cosa que la cantidad de información que recuerda la Inteligencia-Artificial-iA en un momento dado y se mide en Tokens.

Aclaremos algunos conceptos:

- .Qué son los MoEs: Mixture of experts, Esta técnica de Machine-Learning que divide un modelo de Inteligencia-Artificial-iA en subredes separadas, llamada expertos. Estos Sistemas-Expertos se ejecutan uno a unos-pocos para cada entrada. Esta arquitectura de Experts permite la reducción de costes de calculo durante el entrenamiento y se consigue rendimientos mas altos durante la Inferencia. Se activa selectivamente los Sistemas-Expertos necesarios para la tarea, en lugar de todo el modelo de Inteligencia-Artificial-iA.

- .Que son las Ventanas-Contexto-iA: es el texto que la iA puede leer y lo recuerda durante la sesión. El tamaño de la Ventanas-Contexto-iA, es el tamaño asimilado por la iA, este texto se mide en Tokens. Porgamos algún ejemplo de la versión mas básica: GPT-4-estándar 8000-tokens y del modelo Gemini-1.5 de Google 128000-tokens. Estos datos se sitúan cronológicamente a principio del 2024.

- .Qué son los tokens: unidad de testo del modelo, Los tokens son grupos de caracteres que representan la unidad fundamental del texto. Generados por un algoritmo tokenizador, puede ser una palabra pero tiene en cuenta todos los caracteres, hasta los emojis, esto depende del idioma, del modelo utilizado, etc. La proporción adecuada a considerar: (En Inglés: una palabra mas o menos 1.3 tokens) . (En Español: una palabra más o menos 2 tokens).

Acceso

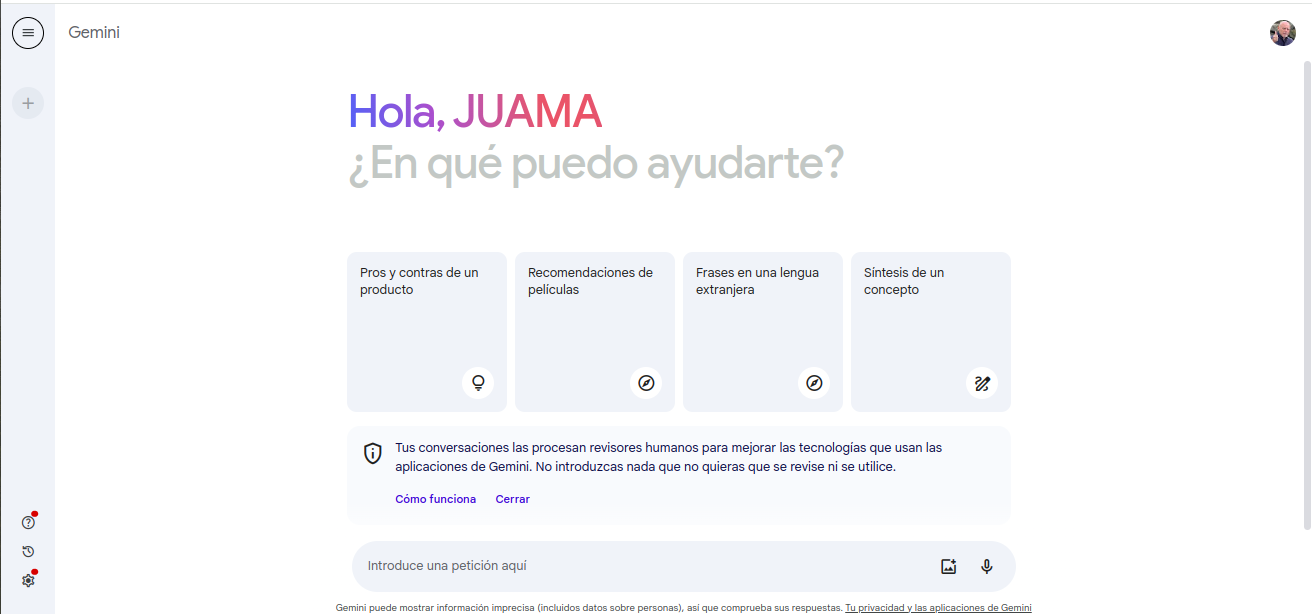

-. Como podemos acceder al modelo Gemini-1.5 de Google por su sitio-Web nos ofrecen las dos versiones Gemini-1.0, por supuesto la versión Gemini-1.5 y diferentes temas interesantes como los encontrados en el menú Acerca de / Descripción general.

-. Como accedemos a Gemini-1.5 para poder probar en el sitio-web después de una breve introducción me encuentro que me cambia el nombre juan por “Hola, JUAMA” ¡quizás una una expresión amigable!.

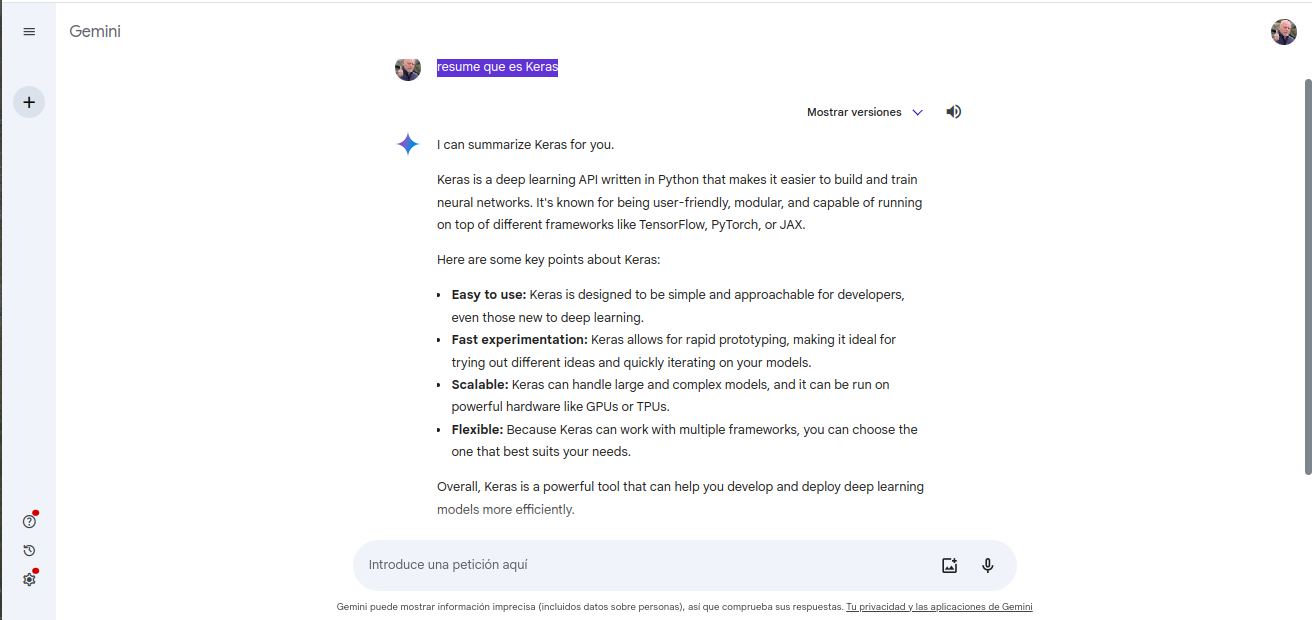

-. Le paso la siguiente pregunta: “resume que es Keras”

-. Nos da un resultado a la pregunta “resume que es Keras” preciso y nos agrega los puntos fuertes de Keras.

-. Pasemos a analizar una imagen introducimos la imagen de este post de Transformers-Arquitectura-Network-Neuronal ¡que nos ofrece! Reconoce el diagrama y nos da una discreción del mismo.

Respuesta:

La imagen que me has enviado muestra la estructura de un Transformer.

Componentes principales de un Transformer:

- Codificador: El codificador procesa la entrada, la cual puede ser una secuencia de palabras, números o cualquier otro tipo de datos. El objetivo del codificador es extraer información relevante de la entrada y representarla en un formato que pueda ser utilizado por el decodificador.

- Decodificador: El decodificador genera la salida, la cual puede ser una traducción, una respuesta a una pregunta o cualquier otro tipo de texto o código. El objetivo del decodificador es utilizar la información proporcionada por el codificador para generar una salida coherente y significativa.

Recopilando:

Este modelo Modelo-Google-iA-Gemini-1.5 nos ofrece un acceso totalmente gratuito, es cierto que me ha gustado su funcionalidad concretamente el de una imagen-diagrama lo interpreta correctamente ¡pero! Le pido que genere un diagrama de un peceptron simple me da el sitio-web donde encorar la petición “no lo genera” si es verdad que ofrece tres discreciones detalladas.

- Referencias: moreluz.entorno

- Referencias: Gemini